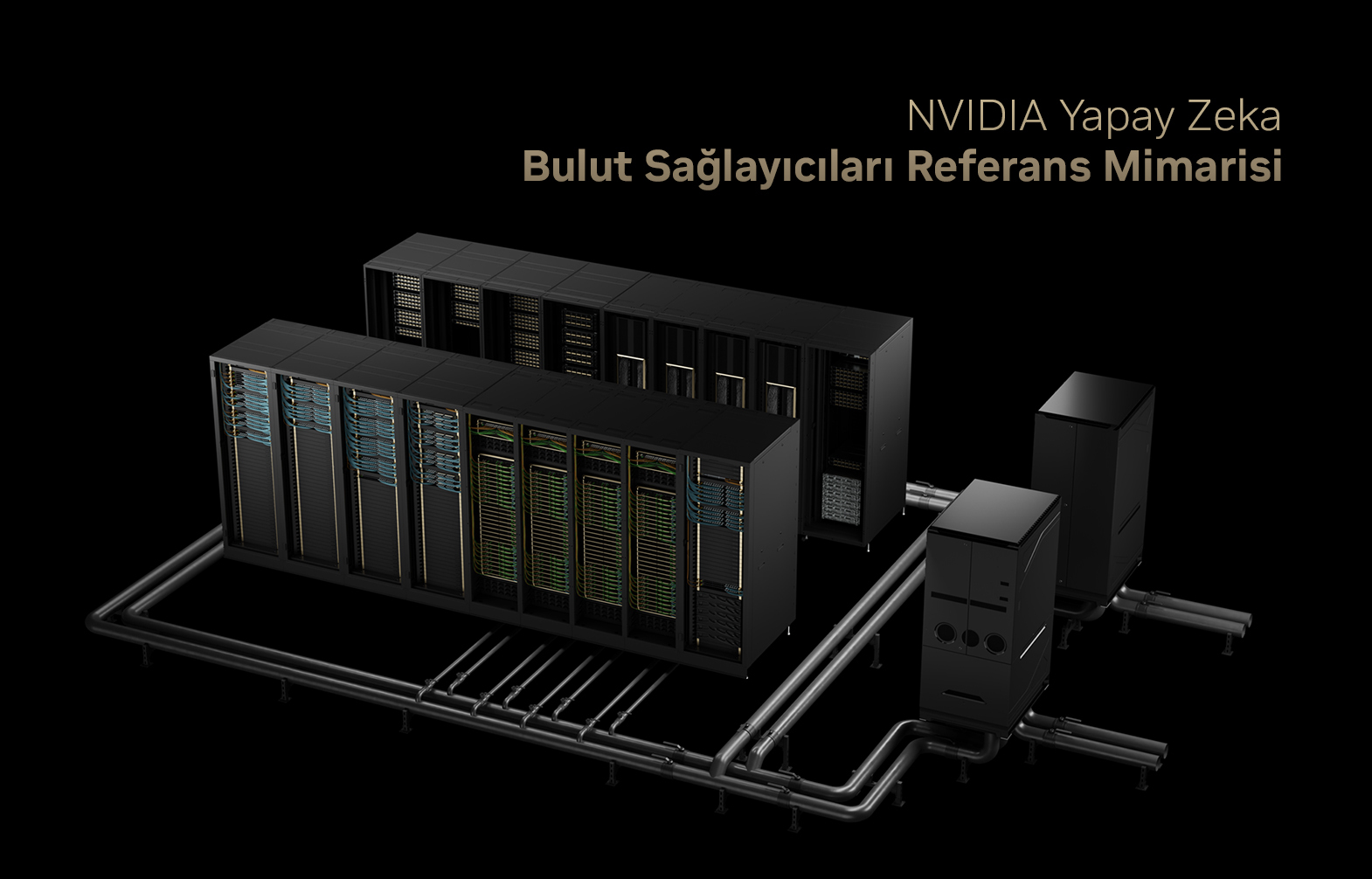

NVIDIA, üretken yapay zeka hizmetleri sunmak isteyen bulut sağlayıcıları için yeni bir referans mimarisi duyurdu.

NVIDIA Cloud Partner referans mimarisi, üretken yapay zeka (Generative AI) ve büyük dil modellerini (LLM’ler) işleyebilen yüksek performanslı, ölçeklenebilir ve güvenli veri merkezleri oluşturmak için bir plan sunmaktadır.

Bu referans mimari, NVIDIA İş Ortağı Ağı bünyesindeki NVIDIA Bulut İş Ortaklarının yapay zeka çözümlerini dağıtma süresini ve maliyetini azaltırken, çeşitli donanım ve yazılım bileşenleri arasında uyumluluk sağlar. Aynı zamanda bulut sağlayıcılarının, kendi altyapılarına yatırım yapmadan üretken yapay zeka ve büyük dil modellerinin gücünden yararlanmak isteyen firmaların yapay zeka hizmetlerine yönelik talebi karşılamasına yardımcı olur.

Üretken yapay zeka ve LLM’ler, firmaların karmaşık sorunlarını çözmek için kullanılır. Bu teknolojiler, belirli bir girdi veya bağlama dayalı olarak metin, görüntü, ses ve video gibi yeni çıktılar üretmek için derin sinir ağlarını kullanır. Üretken yapay zeka ve LLM’ler, kopilotlar, sohbet robotları gibi çeşitli uygulamalarda kullanılabilir.

Ancak, üretken yapay zeka ve LLM’ler, bu iş yüklerini desteklemek için altyapı ve yazılım sağlaması gereken bulut sağlayıcıları için önemli zorluklar oluşturur. Bu teknolojiler büyük miktarda hesaplama gücü, depolama ve ağ bant genişliğinin yanı sıra performans ve verimliliği optimize etmek için özel donanım ve yazılım gerektirir. Örneğin, LLM eğitimi, birçok GPU sunucusunun birlikte çalışmasını, sürekli iletişim kurmasını gerektirir ve veri merkezlerinde hızlı ve verimli iletişim için yüksek performanslı ağlar gerektirir. Daha büyük modellerle üretken yapay zeka çıkarımı da benzer şekilde birden fazla GPU’nun birlikte çalışmasını gerektirir.

Bulut sağlayıcıları, farklı ihtiyaç ve beklentilere sahip birden fazla müşteriye hizmet verdikleri için altyapılarının güvenli, güvenilir ve ölçeklenebilir olmasını sağlamalıdır. Ayrıca, endüstri standartlarına uymaları ve hizmetleri için destek ve bakım sağlamaları gerekir.

NVIDIA Cloud Partner referans mimarisi, bulut sağlayıcılarının farklı kullanım durumlarına yönelik yapay zeka hizmetleri ve iş akışları sunması için kapsamlı, tam yığın donanım ve yazılım çözümü sağlayarak bu zorlukların üstesinden gelir. NVIDIA’nın büyük ölçekli dağıtımlar tasarlama ve oluşturma konusundaki deneyimine dayanan referans mimarisi şunları içerir:

- NVIDIA GPU Sunucuları: Hopper ve Blackwell gibi en son GPU mimarilerini içerir. Yapay zeka iş yükleri için yüksek işlem gücü ve performans sunar.

- Depolama Çözümleri: Yapay zeka ve LLM iş yükleri için optimize edilmiştir. Bu çözümler, NVIDIA DGX SuperPOD ve NVIDIA DGX Cloud için test edilmiş ve doğrulanmıştır.

- Ağ Teknolojileri: NVIDIA Quantum-2 InfiniBand ve Spectrum-X Ethernet ağ teknolojileri, GPU sunucuları arasında hızlı ve verimli iletişim sağlar.

- NVIDIA BlueField-3 DPUs: Yüksek performanslı kuzey-güney ağ bağlantısı sunar ve veri depolama hızlandırma, esnek GPU hesaplama ve sıfır güvenlikli güvenlik özellikleri sağlar.

- İç ve Dış Ağ Yönetimi Çözümleri: AI veri merkezi altyapısını temin etme, izleme ve yönetme için araçlar ve hizmetler sağlar.

- NVIDIA AI Enterprise Yazılımı: Şunları kapsar:

- NVIDIA Base Command Manager Essentials: Bulut sağlayıcıların sunucularını temin etmelerine ve yönetmelerine yardımcı olan bir yönetim aracı.

- NVIDIA NeMo: Bulut sağlayıcıların üretken yapay zeka modellerini eğitmelerine ve ayarlamalarını yapmalarına yardımcı olan bir platform.

- NVIDIA NIM: Üretken yapay zeka dağıtımını hızlandırmak için tasarlanmış, kullanımı kolay mikro hizmetlerden oluşan bir set.

- NVIDIA Riva: Konuşma hizmetleri için tasarlanmış bir platform.

- NVIDIA RAPIDS Spark: Spark iş yüklerini hızlandırmak için tasarlanmış bir hızlandırıcı.

NVIDIA Cloud Partner referans mimarisi, bulut sağlayıcılarına şu avantajları sunar:

- Build, Train and Go: NVIDIA altyapı uzmanları, bulut sağlayıcılarının daha hızlı kullanıma sunması için kümeyi fiziksel olarak kurmak ve sağlamak üzere mimariyi kullanır.

- Hız: Mimari, NVIDIA ve iş ortağı satıcıların uzmanlığını ve en iyi uygulamalarını bir araya getirerek bulut sağlayıcılarının yapay zeka çözümlerinin dağıtımını hızlandırmasına ve rekabet avantajı elde etmesine yardımcı olur.

- Yüksek Performans: Mimari, yapay zeka iş yükleri için optimum performans sağlar.

- Ölçeklenebilirlik: Mimari, bulut tabanlı ortamlar için esneklik sunar ve son kullanıcıların artan taleplerini karşılamak için sorunsuz bir şekilde genişleyebilir.

- Birlikte Çalışabilirlik: Mimarinin çeşitli bileşenleri arasında uyumluluk sağlayarak bileşenler arasındaki entegrasyonu ve iletişimi sorunsuz hale getirir.

- Bakım ve Destek: NVIDIA Bulut İş Ortakları, dağıtım sırasında ve sonrasında ortaya çıkabilecek beklenmedik zorlukların giderilmesine yardımcı olabilecek NVIDIA uzmanlarına erişebilir.

Sonuç olarak, NVIDIA Cloud Partner referans mimarisi, her ölçekten ve sektörden firmanın yapay zeka hizmetlerini kolaylaştırmak amacıyla, bulut sağlayıcılarının yapay zeka veri merkezleri için yüksek performanslı ve ölçeklenebilir altyapıyı kurması ve yönetmesi için kanıtlanmış bir plan sunar.

- NVIDIA’nın en yeni RTX Ada Lovelace serisi ve Ampere serisi masaüstü GPU seçeneklerine buradan ulaşabilirsiniz: https://openzeka.com/urun-kategori/ekran-kartlari/masaustu-ekran-kartlari/

- NVIDIA Ada Lovelace, Ampere ve Hopper mimarisi tabanlı Server GPU’larına buradan ulaşabilirsiniz: https://openzeka.com/urun-kategori/ekran-kartlari/server-ekran-kartlari/

- OpenZeka Profesyonel Seri Hazır İş istasyonlarına buradan ulaşabilir veya projenize özel konfigürasyona sahip sistemler için [email protected] üzerinden bizlere ulaşabilirsiniz.

Yazının kaynağına buradan ulaşabilirsiniz.

OPENZEKA HABERLERİ

OPENZEKA HABERLERİ

Hesaplarınızda paylaşmak ister misiniz?