Yapay zeka modellerinin çıkarım (inference) sürecinde optimize edilmesi söz konusu olduğunda, geliştiricilerin aklına genellikle model sıkıştırma teknikleri gelir: kuantizasyon (quantization), distilasyon (distillation) ve budama (pruning). Bu üçü arasında en yaygın kullanılan yöntem kuşkusuz kuantizasyondur. Bunun başlıca nedeni, kuantizasyonun görev odaklı doğruluk açısından optimize sonrası güçlü performans sunması ve çok sayıda framework tarafından desteklenmesidir.

Ancak kuantizasyonun en büyük zorluğu, özellikle FP32 gibi yüksek hassasiyetli veri türlerinden en yeni ve düşük hassasiyetli format olan FP4’e geçerken, modelin görev bazlı doğruluğunu veya genel performansını korumakta yaşanan zorluklardır.

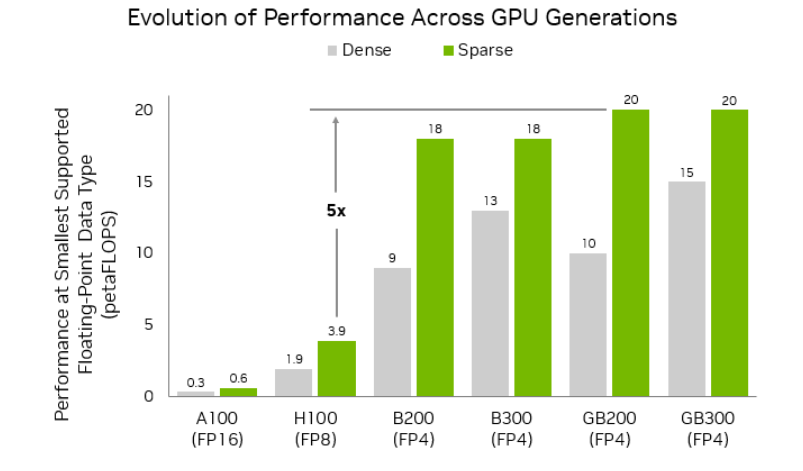

NVIDIA Blackwell mimarisi, FP64, FP32/TF32, FP16/BF16, INT8/FP8, FP6 ve FP4 veri formatlarını destekleyerek geliştiricilere maksimum esneklik sağlar. Aşağıdaki görselde (Şekil 1), NVIDIA Ampere, Hopper ve Blackwell GPU’larında desteklenen en küçük floating proint veri türleri ile bu türlerin yoğun (dense) ve seyrek (sparse) işlemlerindeki performans karşılaştırması yer almakta. Bu da GPU nesilleri arasında veri türü desteği ve performans açısından nasıl bir evrim yaşandığını açıkça ortaya koymaktadır.

Şekil 1. NVIDIA GPU mimarileri genelinde en yüksek düşük hassasiyetli performans

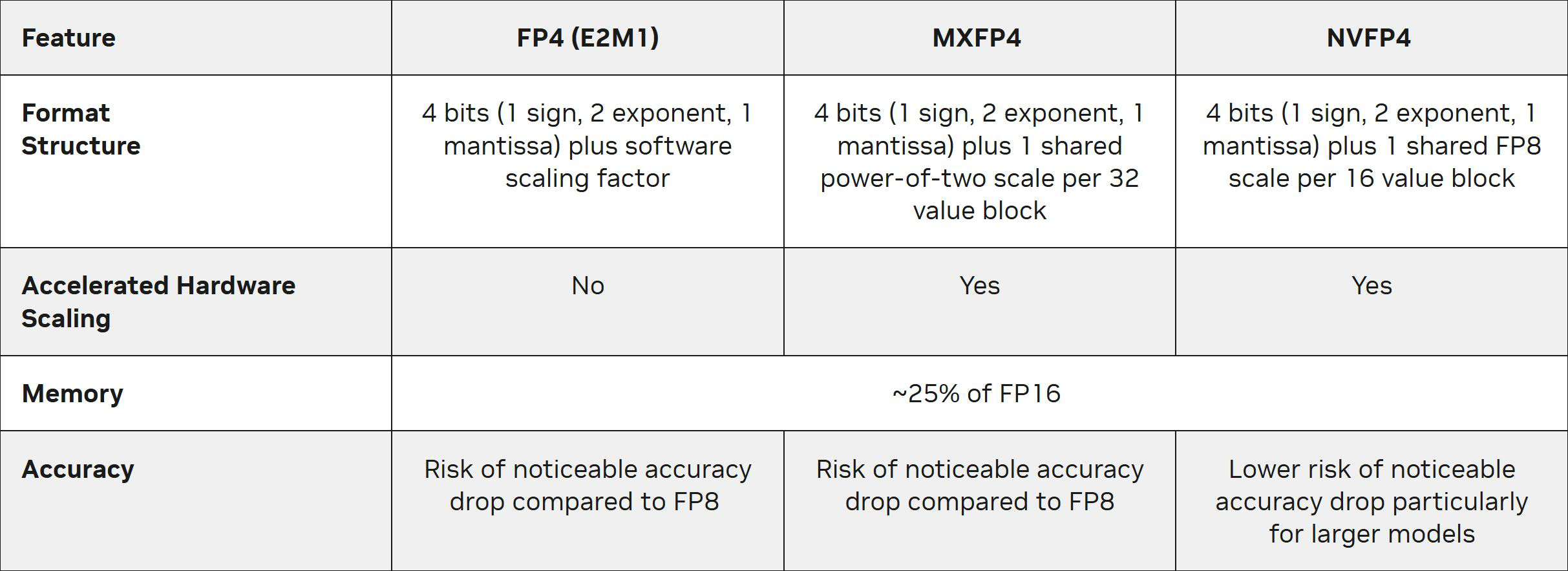

NVIDIA’nın en yeni beşinci nesil Blackwell Tensor Core mimarisi, hem araştırma hem de gerçek dünya uygulamaları için uygun olan ultra düşük hassasiyetli veri formatlarının önünü açıyor. Tablo 1, NVIDIA Blackwell mimarisi tarafından desteklenen üç temel 4-bit floating point formatını karşılaştırıyor: FP4, MXFP4 ve NVFP4. Bu karşılaştırma; yapılarındaki farklılıkları, bellek kullanımlarını ve doğruluk seviyelerini ortaya koyuyor. Tablo aynı zamanda, NVFP4’ün önceki basit formatlardan nasıl ilham aldığını ve bunu yaparken model doğruluğunu nasıl koruduğunu da gösteriyor.

Tablo 1. Blackwell destekli 4 bit kayan nokta biçimlerinin karşılaştırılması

Bu yazıda, son teknoloji bir veri formatı olan NVFP4 tanıtılıyor. NVFP4, Blackwell mimarisi üzerinde çalışan yapay zeka modellerinin daha verimli ölçeklenmesini sağlamak ve ultra düşük hassasiyette bile yüksek doğruluk sunmak amacıyla özel olarak geliştirilmiştir.

NVFP4: NVIDIA Blackwell ile Gelen Yenilikçi 4-Bit Floating Point Formatı

NVFP4, NVIDIA Blackwell GPU mimarisiyle tanıtılan yenilikçi bir 4-bit floating point formatıdır. Düşük bitli “mikro” floating point formatları fikrinden yola çıkan NVFP4, geliştiricilere daha fazla esneklik sunarak seçim yapabilecekleri ek bir format daha sağlar.

NVFP4’ün yapısı, çoğu 4-bit floating point formatına (E2M1) benzerdir: 1 işaret biti, 2 üstel bit ve 1 mantis biti içerir. Bu yapı sayesinde temsil edilen sayılar yaklaşık olarak -6 ile +6 arasında değişir. Örnek olarak, bu aralıkta yer alabilecek değerler şunlardır: 0.0, 0.5, 1.0, 1.5, 2, 3, 4 ve 6 (aynı şekilde negatif karşılıkları da vardır).

Ultra düşük hassasiyetli formatların en büyük zorluklarından biri, farklı büyüklükteki tensör değerleri arasında sayısal doğruluğu korumaktır. NVFP4, bu sorunu çözmek için çıkarım görevlerinde yüksek verimlilik sağlayan iki mimari yenilik ile öne çıkar:

- Yüksek hassasiyetli ölçek kodlaması

- İki seviyeli mikro blok ölçekleme stratejisi

Bu strateji, her 16 değerlik mikro bloğa (tensörün daha küçük alt kümesi) ince taneli bir E4M3 ölçekleme faktörü uygular. Buna ek olarak, her tensör için ikinci bir FP32 ölçek katsayısı da kullanılır. Bu iki seviyeli ölçekleme, değerlerin daha doğru temsil edilmesini sağlar ve kuantizasyon hatasını önemli ölçüde azaltır (Bkz. Şekil 2).

Şekil 2. NVFP4 iki seviyeli ölçekleme, blok başına ve tensör başına hassasiyet yapısı.

Yüksek Hassasiyetli Ölçekleme: Daha Fazla Sinyal, Daha Az Hata

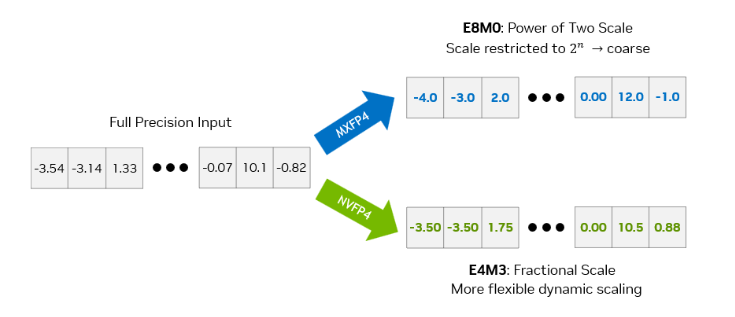

NVFP4, paylaşımlı mikro blok ölçeklemeden en yüksek verimi elde edebilmek için blokları E4M3 FP8 hassasiyetinde kodlar. NVFP4’te kullanılan E4M3 FP8 formatı, iki katının kuvveti olmayan (non-power-of-two) ve kesirli hassasiyete sahip ölçekleme katsayılarını mümkün kılar. Bu ek esneklik, tensörün gerçek dağılımına daha yakın bir temsil yapılmasını sağlar ve veri kaybını azaltarak daha doğru kodlama sunar. Şekil 3, tam hassasiyetli bir giriş matrisinin, E8M0 ve E4M3 ölçekleme kullanılarak kuantize edilmiş çıktılarla karşılaştırmasını göstermektedir.

Şekil 3. İki kuvveti ile kesirli ölçeklemeyi vurgulayan niceleme hassasiyetinin karşılaştırılması (basitlik için ikinci seviye FP32 ölçeklemesi çıkarılmıştır)

E4M3 formatının daha hassas ölçekleme katsayıları sunmasının bir dezavantajı, ölçek değerlerinin kapsadığı aralığın daralmasıdır. Bu sınırlılığı dengelemek amacıyla, ikinci seviyede bir ölçekleme katsayısı devreye girer.

Bu ikinci seviye ölçekleme, her tensör için ayrı ayrı ve FP32 hassasiyetinde uygulanır (Bkz. Şekil 2). Böylece, orijinal tensörün dağılımı yeniden ayarlanarak mikro blokların E4M3 ölçekleme ile etkili biçimde kodlanması sağlanır.

Şekil 4. E8M0 ile E4M3 ölçekleme faktörlerini kodlarken kuantizasyon hatasının karşılaştırılması (basitlik için ikinci seviye FP32 ölçeklemesi çıkarılmıştır)

Şekil 4’teki animasyon, Şekil 3’te gösterilen matris dönüşümünün sayı doğrusu üzerinde görselleştirilmiş bir temsilidir. Bu örnekte, orijinal tam hassasiyetli değerler (sarı dairelerle gösterilir), kuantize veri tipinin dinamik aralığında karşılık geldikleri konumlara eşlenmiştir.

Bu eşlemelerin kalitesini ölçmek için kullanılan metrik, orijinal değerlerden kuantize temsillere olan farkların ortalama kare hatasıdır (MSE). Daha düşük MSE daha iyi sonuç anlamına gelir ve E4M3 formatı için ortalama MSE yalnızca 0.08’dir.

E4M3’ü daha iyi yapan şey, her 16 değerlik blok için en uygun kesirli ölçekleme katsayısını seçmesidir. Bu sayede, o blokta yer alan tüm değerlerin kare (veya mutlak) hata toplamı genellikle E8M0 formatıyla karşılaştırıldığında daha düşük olur.

Bunu şöyle özetleyebiliriz:

E8M0: Ölçek katsayısını en yakın 2n2^n2n değerine “kilitler”. Bu, özellikle bloktaki en büyük değer (amax) için yüksek kuantizasyon hatası oluşturabilir ve genellikle tüm blokta daha fazla bilgi kaybına yol açar.

E4M3: Tüm bloğun genel hatasını en aza indirecek tek bir ölçek katsayısı bulur. Bazı bireysel değerlerde küçük doğruluk kayıpları yaşanabilir, fakat blok genelinde daha yüksek doğruluk korunur.

Peki Neden Hâlâ E8M0 Kullanılsın?

E8M0, hesaplama açısından daha basittir; ayrıca her tensör için ek bir yazılımsal ölçekleme katsayısı gerektirmez. Özellikle, ölçekleme hassasiyetine duyarlılığı düşük olan aktivasyonlar ve ağırlıklar için yeterli olabilir.

Öte yandan E4M3, her küçük değer bloğu için en iyi ölçekleme katsayısını dinamik olarak ayarlayarak, daha geniş giriş aralıklarında daha isabetli bir temsil sunar.Bu ek esneklik, toplam yuvarlama hatasını azaltır ve NVFP4 ile 4-bit kuantizasyonda model zekâsını korumayı mümkün kılar.

NVIDIA’nın beşinci nesil Blackwell Tensor Core mimarisi, NVFP4 formatını donanımsal olarak destekler ve FP4 verisinin mikro ölçekli işlenmesini — veri gruplama, dinamik ölçekleme ve 4-bit matris işlemleri dahil — otomatik olarak yönetir.

Verimli Model Sıkıştırma için Mikro Blok Ölçekleme

NVFP4’ün temel bileşenlerinden biri, block floating-pointdir. Bu yöntemde, mikro bloklar ortak bir ölçek katsayısını paylaşır. NVFP4, blok başına düşen öğe sayısını 32’den 16’ya indirerek, MXFP4’e kıyasla daha finer-grained bir ölçekleme sağlar.

Yapay zeka modellerindeki büyük tensörlerde, büyük ve küçük sayıların karışımı sıkça görülür. Bu durumda tek bir “genel” ölçekleme katsayısı kullanmak, küçük değerleri yeterince temsil edemediği için kuantizasyon hatalarını artırabilir ve modelin performansını düşürebilir.

NVFP4’ün daha sıkı blok yapısı, verinin yerel dinamik aralığına iki kat daha fazla uyum sağlama imkânı sunar. Bu sayede kuantizasyon kaynaklı hatalar önemli ölçüde azaltılır.

NVFP4’ün kuantizasyon doğruluğunu nasıl artırdığını daha iyi anlamak için, onu doğrudan selefi olan MXFP4 ile karşılaştırmak faydalı olur.

Her iki format da gruplandırılmış değer bloklarına ve paylaşılan ölçek katsayılarına dayanır. Ancak NVFP4’ü farklı ve etkili kılan temel yenilik, blok boyutunun yarıya düşürülmesi (32 → 16) ve ölçeklemedeki esneklik ile ilgilidir.

Blok boyutunun küçülmesi, verinin dinamik aralığına daha yerel ve hassas şekilde uyum sağlanmasını mümkün kılar. Bu da özellikle model ağırlıkları veya aktivasyonlarındaki küçük ama önemli farkların korunmasını kolaylaştırır.

Şekil 5, bu yaklaşımın uygulamada nasıl çalıştığını görsel olarak ortaya koymaktadır.

Şekil 5. NVFP4, mikro blok ölçeklemesiyle MXFP4’e kıyasla daha ince taneli kuantizasyona olanak tanır.

Nasıl Çalışır?

Her 16 değerlik blok içinde, NVFP4 formatında kodlanan her bir 4-bit değer aşağıdaki formül ile ölçeklenerek gerçek değeri elde edilir:

Bu denklemdeki sss, her blok için dinamik olarak hesaplanan yüksek hassasiyetli bir FP8 (E4M3) ölçek katsayısıdır. Amaç, bu katsayıyı öyle seçmektir ki, blok içindeki tüm değerlerin toplam kuantizasyon hatası minimuma insin.

Her 16 öğelik grup için bu ölçek katsayısı yeniden hesaplandığı için, NVFP4:

- 4-bit hassasiyet düzeyinde çalışırken bile kuantizasyon hatasını en aza indirir,

- Aynı zamanda daha yüksek hassasiyetli formatlara kıyasla bellek ve hesaplama maliyetini ciddi oranda düşürür.

Bu yapı sayesinde NVFP4 yalnızca düşük hassasiyetli bir veri formatı olmakla kalmaz, aynı zamanda model zekasını koruma konusunda da büyük ilerleme sunar.

NVFP4 ve FP8 Karşılaştırması: Model Performansı ve Bellek Verimliliği

Kuantizasyonun sağladığı kazanımlar, esas olarak iki temel faktöre dayanır:

- Bellek yükünün azaltılması

- Hesaplama işlemlerinin sadeleştirilmesi

Bu iki etken, bellek bant genişliği üzerindeki baskıyı azaltır ve bu da çıktı token üretim hızını (output token throughput) iyileştirebilir.

Ayrıca, attention katmanlarındaki işlemlerin sadeleşmesi sayesinde, uçtan uca gecikme süresi (latency) de azalabilir—özellikle prefill aşamasında doğrudan performans artışı sağlar.

Model Performansı

Çıkarım (inference) performansını optimize ederken asıl hedef, modelin zekâsını ve doğruluğunu korumaktır. İşte NVFP4 tam da bu dengeyi sağlamak için tasarlanmıştır.

NVFP4’ün temel vaadi şudur: Modeli 4-bit’e kuantize ederken hem çıkarım performansında büyük kazançlar elde etmek hem de model doğruluğunda minimum etkiyle bu süreci tamamlamak.

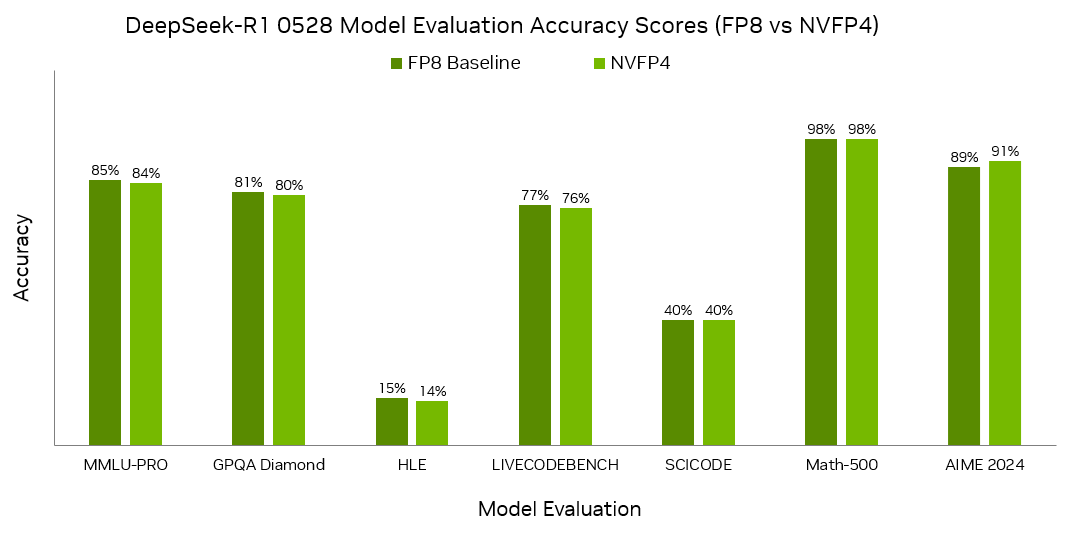

Şekil 6, bu dengeyi net biçimde ortaya koyar. DeepSeek-R1-0528 modeli üzerinde yapılan yedi farklı değerlendirme üzerinden, FP8 ve NVFP4 ile kuantize edilmiş sürümler arasında neredeyse fark edilmeyecek düzeyde doğruluk farkı olduğunu göstermektedir.

Şekil 6. NVFP4, FP8’den FP4 kuantizasyonuna kadar minimum doğruluk kaybına olanak tanır.

Gelişmiş Ağ Altyapısı

Yapılan analiz, DeepSeek-R1-0528 modeli için FP8 formatından NVFP4’e geçişte, eğitim sonrası kuantizasyon (PTQ) kullanıldığında, önemli dil modelleme görevlerinde doğruluk kaybının %1 veya daha az olduğunu ortaya koyuyor.

Hatta bazı durumlarda NVFP4, FP8’e göre daha iyi sonuçlar bile verebiliyor. Örneğin AIME 2024 değerlendirmesinde, NVFP4 doğruluk açısından %2 daha iyi performans göstermiştir.

Bellek Verimliliği

FP8, NVIDIA’nın Hopper ve Blackwell mimarileri tarafından desteklenmektedir ve önceki en küçük 16-bit floating point formatları olan FP16/BF16’a kıyasla bellek kullanımı, gecikme ve aktarım hızı açısından önemli avantajlar sağlamıştır.

Şimdi ise NVFP4, Blackwell üzerinde çalışan yapay zekâ iş yükleri için hem hassas hem de son derece kompakt bir veri formatı sunuyor.

- NVFP4, her 16 değer için bir adet 4-bit değer,ve küçük bir ek yük olarak bir FP8 ölçek katsayısı saklar (ortalama 4.5 bit/değer),ayrıca tüm tensör için bir FP32 ikinci seviye ölçek katsayısı kullanır.

Bu yapı sayesinde:

- FP16’ya göre yaklaşık 3.5 kat,

- FP8’e göre ise yaklaşık 1.8 kat daha az bellek kullanımı sağlanır.

Bu avantajlar, NVIDIA GB300 NVL72 sistemine ölçeklendiğinde çok daha dikkat çekici hale gelir. Bu sistem, her biri bir NVIDIA Grace CPU ve iki NVIDIA Blackwell Ultra GPU içeren 36 Grace Blackwell Ultra Superchip barındırır. Toplamda sistem başına 40 TB bellek kapasitesi sunar. Bu büyük HBM ve Grace bellek bütçesi, NVFP4’ün getirdiği yüksek doğruluk ve düşük bellek kullanımı ile birleştiğinde, test zamanı ölçekleme (test-time scaling) gibi büyük ölçekli yapay zeka çıkarım görevlerinde karşılaşılan zorlukların aşılmasında ciddi avantajlar sunar.

FP4 ile Enerji Verimliliği

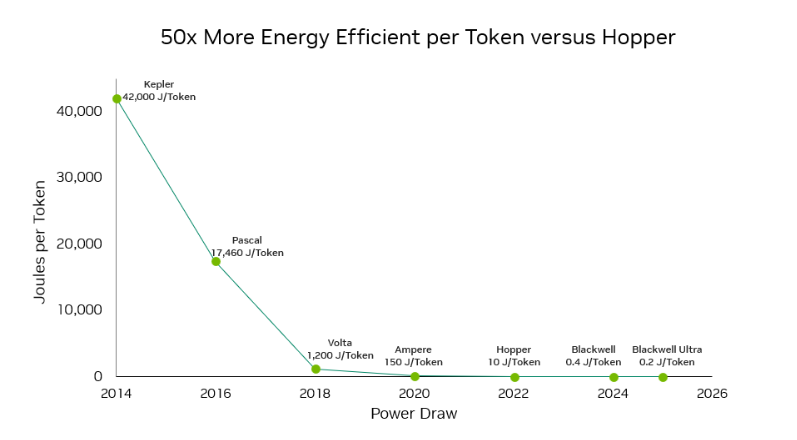

Düşük hassasiyetli hesaplama, yalnızca çıkarımı hızlandırmak ve bellek kullanımını azaltmakla kalmaz, aynı zamanda birim watt başına performansı da artırır.

Her 4-bit işlem, daha yüksek hassasiyetli veri türlerine kıyasla hem veri taşıma hem de aritmetik işlemler açısından daha az enerji tüketir.

Blackwell Tensor Core mimarisinde yer alan sıvı soğutma gibi donanım yenilikleri ve FP4 desteği, Blackwell ve Blackwell Ultra sistemlerinin önemli enerji verimliliği kazançları sunmasını sağlar.

NVIDIA’nın H100 Tensor Core mimarisiyle karşılaştırıldığında:

-Blackwell mimarisi 25 kata kadar,

-Blackwell Ultra ise 50 kata kadar daha fazla enerji verimliliği sağlayabilir.

Şekil 7, bu enerji tasarrufu farkını görsel olarak ortaya koymaktadır.

Şekil 7. NVFP4, GPT-MoE 1.8T için Blackwell Ultra ile Hopper arasında token başına 50 kata kadar enerji verimliliği sağlıyor.

NVFP4 ile Başlayın

Yapay zekaya yönelik taleplerin hızla arttığı günümüzde, çıkarım ekosistemi NVFP4 hassasiyetini hızla benimsemeye başladı.

Modelinizi NVFP4 formatına kuantize etmek istiyorsanız, NVIDIA TensorRT Model Optimizer ve LLM Compressor, bu süreci kolaylaştıran entegre iş akışları sunuyor

Artık PTQ (eğitim sonrası kuantizasyon), QAT (kuantizasyonla birlikte eğitim) ve diğer gelişmiş kuantizasyon tekniklerini uygulamak her zamankinden daha kolay.

Kuantizasyon işlemi tamamlandıktan sonra:

- NVFP4 formatındaki model, Unified Hugging Face Checkpoint olarak kolayca dışa aktarılabilir.

- Bu modeller, NVIDIA TensorRT-LLM ve vLLM üzerinde doğrudan dağıtılabilir. Her iki framework de erken NVFP4 desteğine sahiptir. Yakında SGLang için de destek geliyor.

- TensorRT Model Optimizer, yalnızca LLM’leri değil, LLM dışındaki modelleri de kuantize edebilir ve ONNX formatına dışa aktarım desteği sunar.

Üstelik sıfırdan başlamak zorunda da değilsiniz:

Hugging Face üzerinde, NVFP4 formatında önceden kuantize edilmiş ve hemen kullanılmaya hazır modeller yer alıyor. Bunlar arasında:

- DeepSeek-R1-0528

- Llama 3

- FLUX.1-dev gibi popüler modeller de mevcut.

İster sıfırdan optimize edin ister hazır modellerle başlayın, NVFP4 gerçek dünya uygulamalarında hızla yaygınlaşıyor.

Yakında daha fazla öğretici içerik ve örnek kodlar da sizlerle olacak.

Mimariniz Hazır mı?

Ultra düşük hassasiyetli veri formatlarının sunduğu bu devrimsel performans ve enerji verimliliğinden tam anlamıyla yararlanmak, yalnızca yazılım optimizasyonlarıyla sınırlı değil. NVFP4 gibi yenilikçi formatların potansiyelini gerçek dünyada ortaya çıkarmak için donanım mimarisinin de bu teknolojiye hazır olması gerekiyor.

NVIDIA Blackwell destekli sistemler, yüksek bellek bant genişliği, güçlü paralel hesaplama kapasitesi ve düşük güç tüketimi ile NVFP4 çıkarımı için ideal altyapıyı sunar. Modelinizi NVFP4 ile kuantize ettiğinizde, bu verimliliği performansa dönüştürmek için arka planda çalışan sunucu sistemlerinizin gücü kritik hale gelir.

Bu noktada, yüksek yoğunluklu, enerji verimli ve NVFP4 uyumlu sunucu çözümlerimizi incelemeyi unutmayın. Gelişmiş yapay zeka iş yükleriniz için optimize edilmiş bu sistemler, yeni nesil çıkarım görevleri için hazır.

Sunucu çözümlerimizi inceleyin: https://openzeka.com/urun-kategori/sunucular/

OPENZEKA HABERLERİ

OPENZEKA HABERLERİ

Hesaplarınızda paylaşmak ister misiniz?