NVIDIA Dynamo, yüksek verimlilik ve düşük gecikme avantajlarıyla, üretken yapay zeka ve akıl yürütme temelli modellerin büyük ölçekli ve dağıtık sistemlerde kolayca devreye alınmasını sağlar.

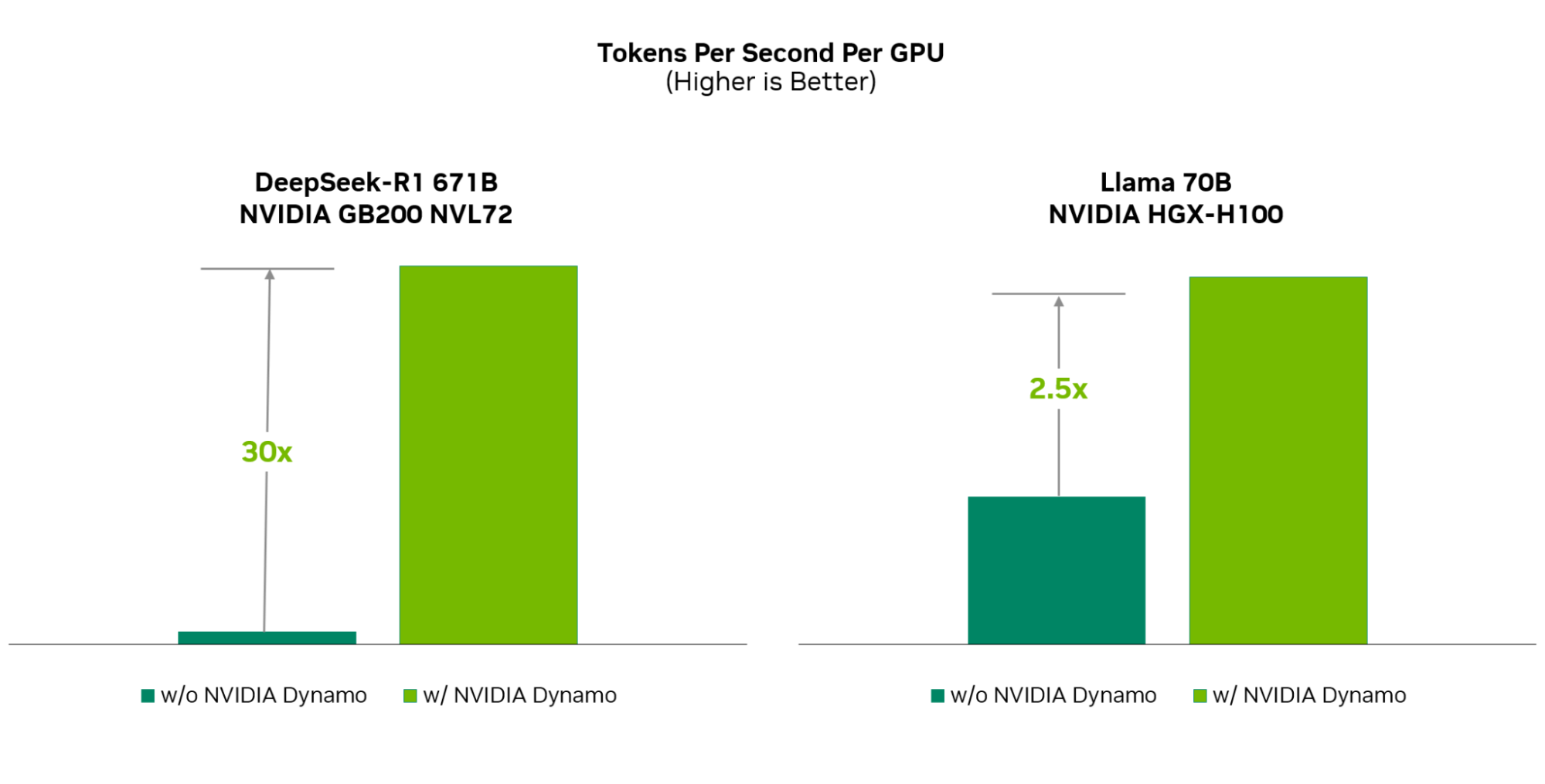

NVIDIA Blackwell platformunda, açık kaynaklı DeepSeek-R1 modelleriyle yapılan testlerde, istek karşılama kapasitesinde 30 kata varan artış elde edilmiştir.

PyTorch, SGLang, NVIDIA TensorRT-LLM ve vLLM gibi açık kaynak araçlarla uyumlu çalışan Dynamo, geliştiricilere modellerini daha hızlı ve verimli dağıtma olanağı sunar. Bu sayede, hızla büyüyen çıkarım teknolojileri ekosisteminde güçlü bir yer edinir.

Dynamo’nun performans artırıcı başlıca özellikleri:

- Ayrıştırılmış “prefill” ve “decode” aşamaları: Her GPU’dan maksimum verim alınmasını sağlar.

- Dinamik GPU planlaması: İş yüküne göre kaynaklar akıllıca tahsis edilir.

- LLM farkındalıklı yönlendirme: KV önbellek tekrar hesaplamalarını önleyerek maliyeti düşürür.

- Hızlandırılmış asenkron veri aktarımı: GPU’lar arası veri akışını hızlandırarak gecikmeleri azaltır.

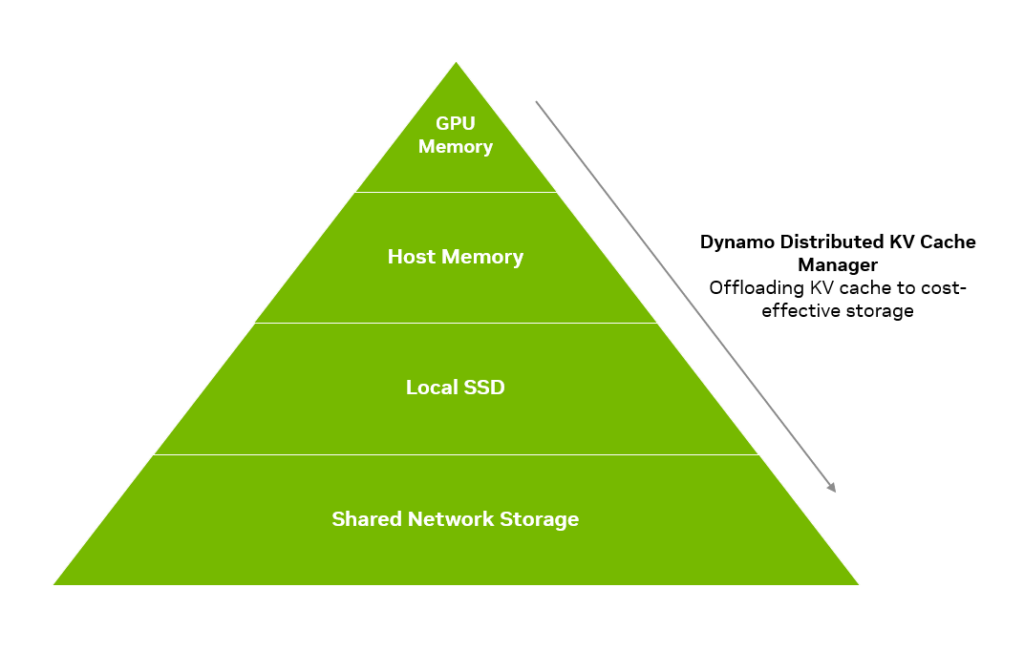

- Katmanlı bellek yapısı: KV önbellek, farklı bellek katmanları arasında etkin şekilde taşınabilir.

Dynamo’ya GitHub’daki ai-dynamo/dynamo reposu üzerinden erişilebilir. Kurumsal kullanıcılar içinse, NVIDIA AI Enterprise kapsamında sunulan NIM mikro servisleri (detaylı bilgi için bakınız: https://blog.openzeka.com/ai/nvidia-nim-olceklenebilir-yapay-zeka-cikarimi-icin-gelistirilmis-mikro-hizmetler/) ile desteklenmektedir.

Bu paylaşımda, NVIDIA Dynamo’nun mimarisi ve temel bileşenleri tanıtılırken, üretken yapay zeka modellerinin tek bir GPU’dan binlercesine kadar ölçeklenmesini mümkün kılan ayrıştırılmış, maliyet etkin bir altyapının nasıl sunulduğu açıklanmaktadır.

Çoklu Düğüm Sistemlerde Yapay Zeka Çıkarım Performansını Artırmak

Yapay zeka çıkarımı, geliştiricilere akıl yürütme temelli modelleri iş akışlarına entegre etme imkanı sunarak yepyeni ve çığır açan uygulamaların önünü açıyor. Bu sayede uygulamalar, kullanıcıları daha doğal ve sezgisel biçimde anlayıp etkileşim kurabiliyor. Ancak bu ilerleme beraberinde yüksek ve sürekli artan işlem maliyetlerini getiriyor. Yapay zekaya olan kesintisiz talebi karşılamak isteyen kurumlar için modelleri uygun maliyetle ölçeklendirmek ciddi bir zorluk haline geliyor.

NVIDIA, 2018 yılında Triton Inference Server’ı tanıttığında, amacı hem yapay zeka inovasyonunu hızlandırmak hem de çıkarım maliyetlerini azaltmaktı. Triton, TensorFlow, PyTorch, ONNX ve OpenVINO gibi farklı framework’lerle çalışan çıkarım çözümlerini tek bir açık kaynaklı platformda birleştirerek bu alanda bir ilki gerçekleştirdi. Bu yaklaşım, geliştiriciler için çıkarım maliyetlerini düşürürken pazara çıkış süresini (TTM) ciddi biçimde kısalttı.

Bugün geldiğimiz noktada açık kaynak yapay zeka modellerinin boyutu yaklaşık 2.000 kat büyüdü. Bu büyük modeller artık, birden fazla modelin birlikte çalıştığı agentic yapay zeka (detaylı bilgi için bakınız: https://blog.openzeka.com/ai/agentic-ai-gelistirmek-icin-nvidia-nemotron-modelleri/) iş akışlarına daha sık entegre ediliyor.

Bu gelişmeler, çıkarım sistemlerinin üretim ortamlarında çok sayıda düğüme (node) dağıtılmasını gerekli kılıyor. Bunun sonucunda, geniş GPU altyapıları arasında hassas bir orkestrasyon ve koordinasyon ihtiyacı doğuyor. Üstelik ayrıştırılmış çıkarım (disaggregated inference) gibi optimizasyon tekniklerinin benimsenmesiyle sistemlerin karmaşıklığı daha da artıyor. Bu da GPU’lar arasında veri paylaşımının ve senkronizasyonun daha verimli yapılmasını zorunlu hale getiriyor.

Tüm bu zorluklara çözüm olarak NVIDIA Dynamo geliştirildi.

Triton’un başarısından ilham alan Dynamo, çok düğümlü (multinode) dağıtık ortamlarda üretken yapay zeka modellerini yüksek verimlilikle çalıştırmak üzere modüler bir mimariyle tasarlandı. Dynamo, çıkarım iş yüklerinin GPU düğümleri arasında sorunsuz şekilde ölçeklenmesini sağlarken, dinamik GPU işçi tahsisi sayesinde talep dalgalanmalarına uyum sağlar ve çok modelli iş akışlarında oluşabilecek darboğazları önler.

Dynamo, NVIDIA TensorRT-LLM, vLLM ve SGLang gibi önde gelen LLM çerçevelerini destekler. Aynı zamanda, çıkarım sürecinin farklı aşamalarını farklı GPU’lara dağıtan ayrıştırılmış çıkarım (disaggregated serving) gibi yeni nesil LLM optimizasyon teknikleriyle sistem performansını en üst düzeye taşır.

NVIDIA GB200 NVL72 ile Yapay Zekâ Çıkarımında 30 Kata Kadar Performans Artışı

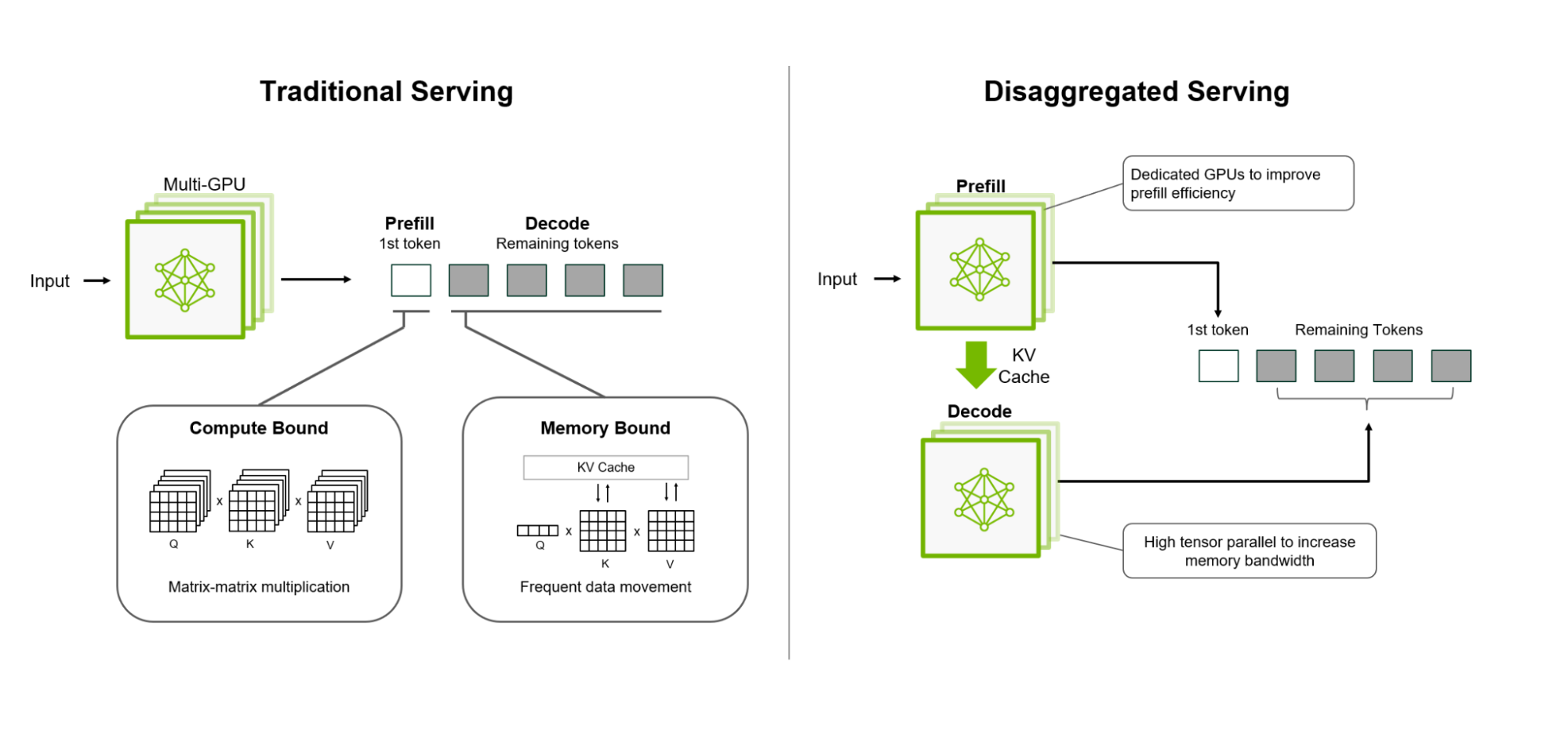

Geleneksel büyük dil modeli (LLM) (detaylı bilgi için bakınız: LLM Nedir? ) dağıtımlarında, çıkarımın prefill (ön hazırlık) ve decode (çözümleme) aşamaları genellikle aynı GPU veya düğümde yürütülüyordu. Ancak bu iki aşama farklı kaynak ihtiyaçlarına sahip olduğundan, bu yaklaşım performans optimizasyonunu sınırlıyor ve GPU kaynaklarının verimli kullanımını engelliyordu.

Prefill aşaması, kullanıcı girdisini analiz edip ilk çıktı token’ını üretir ve yoğun işlem gücü gerektirir. Decode aşaması ise sonraki token’ları üretir ve daha çok belleğe ihtiyaç duyar.

Bu iki farklı karakterdeki işlem basamağının aynı donanımda bir arada yürütülmesi, özellikle uzun giriş dizilerinde kaynak israfına yol açar. Ayrıca, her aşamanın farklı donanım gereksinimi, model paralelliği açısından da esneklik kaybına neden olur.

Bu zorlukların önüne geçmek amacıyla geliştirilen ayrıştırılmış çıkarım (disaggregated serving) yöntemi, prefill ve decode aşamalarını farklı GPU’lara veya düğümlere dağıtarak her birini bağımsız olarak optimize etmeyi mümkün kılar.

- Örneğin, prefill aşamasında düşük tensor paralelliği kullanılarak iletişim yükü azaltılabilir.

- Decode aşamasında ise yüksek tensor paralelliği, bellek yönetimini iyileştirir.

Bu esnek yaklaşım, kaynak kullanımını optimize eder, çıkarım maliyetlerini düşürür ve TTFT (Toplam Geçiş Süresi) ile ITL (Token Arası Gecikme) gibi hizmet seviyesi hedefleri üzerinde daha hassas kontrol sağlar.

NVIDIA Dynamo, bu mimariyi NVIDIA GB200 NVL72 platformunda DeepSeek-R1 modeliyle test ettiğinde, sunulan istek sayısında 30 kata kadar artış sağladı. Aynı zamanda, NVIDIA Hopper platformunda Llama 70B modeliyle yapılan testlerde, performans iki kattan fazla iyileştirildi.

Şekil 1. Parçalanmış sunum, performansı optimize etmek için ön doldurma ve kod çözmeyi farklı GPU’larda ayırır.

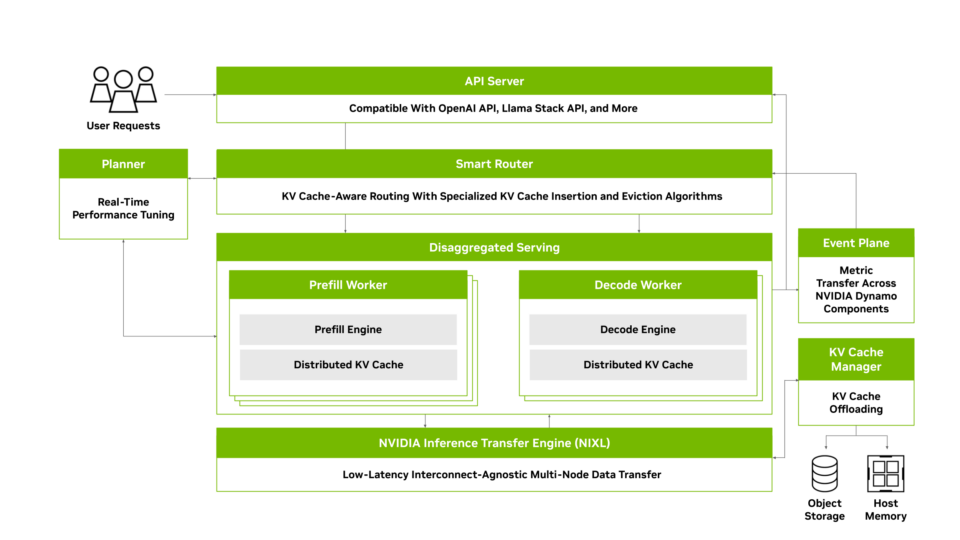

NVIDIA Dynamo’nun Dört Temel Bileşeni

- Dynamo Planlayıcı (Planner): GPU kaynaklarını iş yüküne göre otomatik ve dengeli bir şekilde tahsis eder.

- Akıllı Yönlendirici (Smart Router): KV önbellek kullanımını optimize ederek gereksiz hesaplamaları önler.

- Dağıtık KV Önbellek Yöneticisi (Distributed KV Cache Manager): Düşük erişimli önbellek verilerini uygun maliyetli bellek katmanlarına taşır.

- Inference Transfer Kütüphanesi (NIXL): Donanım ve ağdan bağımsız, hızlı ve tutarlı veri aktarımı sağlar.

Şekil 2. NVIDIA Dynamo, NVIDIA GB200 NVL72’de DeepSeek-R1 671B modelini çalıştırırken olağanüstü bir verim performansı sunarak performansı 30 kat artırır. NVIDIA Hopper GPU’larında çalışan Llama 70B modelinde performansı iki katından fazla artırır.

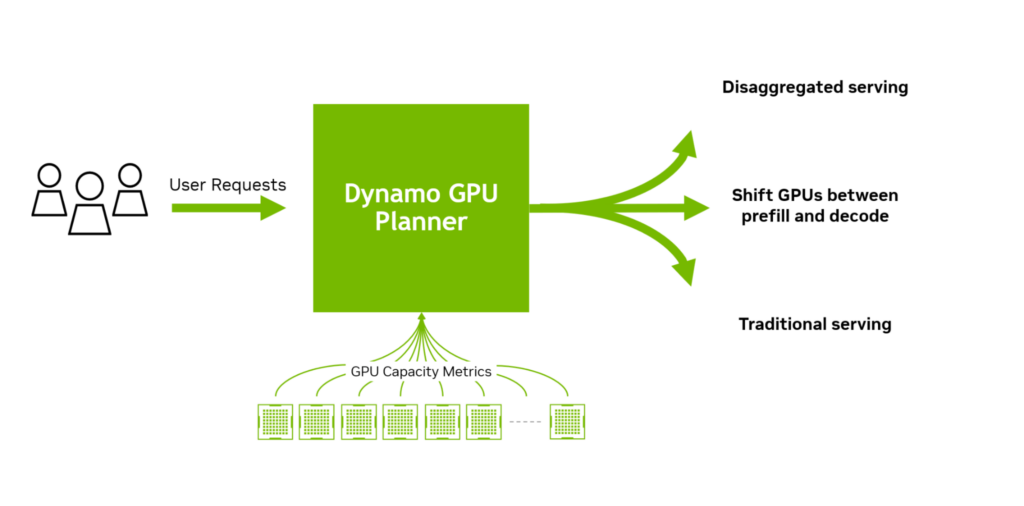

NVIDIA Dynamo Planlayıcı: Dağıtık Çıkarımda GPU Kaynaklarının Akıllı Optimizasyonu

Büyük ölçekli, dağıtık ve ayrıştırılmış çıkarım sistemlerinde GPU kaynaklarının etkin yönetimi, hem maksimum işlem hacmi hem de minimum gecikme sağlamak açısından kritik öneme sahiptir. Ayrıştırılmış çıkarım genel olarak performansı artırsa da, her senaryoda en verimli çözüm olmayabilir.

Örneğin; uzun giriş dizilerine (ISL) ve kısa çıktı dizilerine (OSL) sahip özetleme isteklerinin yoğunlaştığı bir senaryoda, prefill GPU’ları hızla aşırı yüklenebilir. Buna karşılık, decode GPU’ları büyük ölçüde atıl kalabilir. Bu durumda, decode GPU’larının hem prefill hem de decode işlemlerini birlikte yürütebilmesine izin vermek veya decode GPU’larını geçici olarak prefill görevlerine yönlendirmek çok daha verimli bir çözüm sunabilir.

Bu tür kararların alınması için bazı faktörlerin dikkatle analiz edilmesi gerekir:

- Prefill ve decode aşamaları arasında KV önbellek aktarım süresi,

- Her GPU’nun bekleyen istek kuyruğu,

- Ayrıştırılmış ve birleşik yapılandırmaların öngörülen işlem süreleri.

Yüzlerce GPU’nun bulunduğu ortamlarda bu kararlar oldukça karmaşık hale gelir.

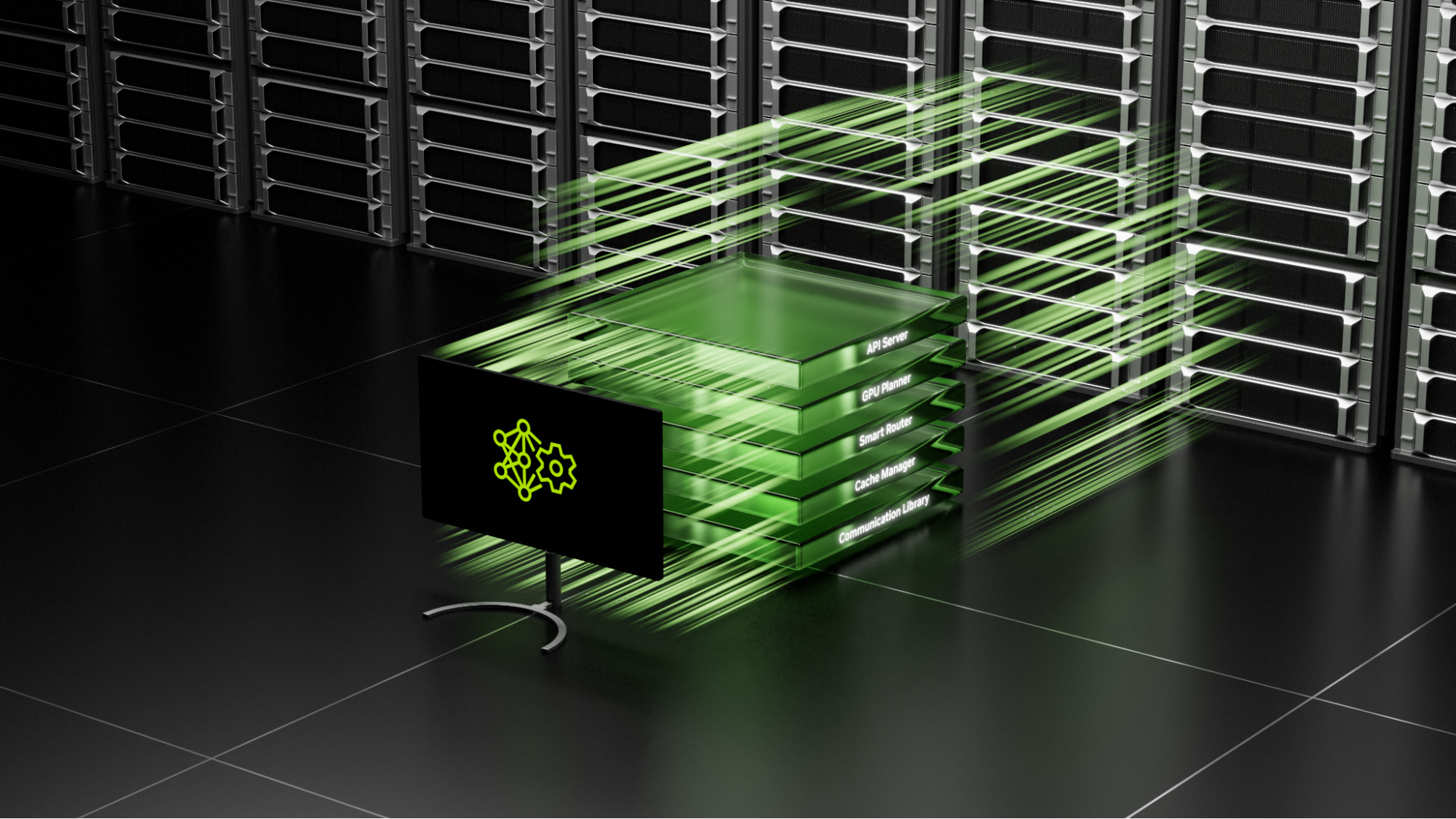

Şekil 3. NVIDIA Dynamo mimarisi

işte bu noktada NVIDIA Dynomo Planlayıcı devreye girer.

Dynamo Planlayıcı, sistemdeki GPU kapasitelerini anlık olarak izler, TTFT (Toplam Geçiş Süresi) ve ITL (Token Arası Gecikme) gibi hizmet seviyesi hedeflerini (SLO’lar) gözeterek, gelen isteklerin ayrıştırılmış mı yoksa birleşik mi sunulacağını, hangi aşamaya ek GPU tahsisi gerekeceğini akıllı biçimde belirler.

Sonuç olarak, GPU kaynakları prefill ve decode arasında optimum şekilde paylaştırılır, iş yükü değişimlerine anında yanıt verilir ve sistemin sürekli en yüksek performansta çalışması sağlanır.

Şekil 4. GPU Planlayıcısı, gelen isteklerin nasıl karşılanacağı veya GPU çalışanlarının nasıl tahsis edileceği konusunda en iyi kararı vermek için GPU kapasite ölçümlerini analiz eder.

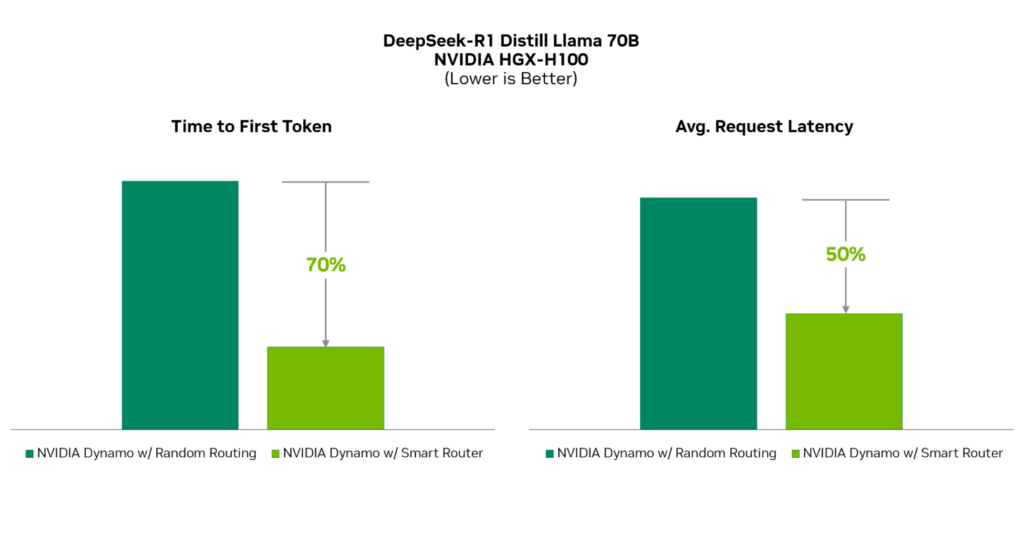

NVIDIA Dynamo Akıllı Yönlendirici: KV Önbelleği Yeniden Hesaplama Maliyetlerini Azaltır

Büyük Dil Modelleri (LLM’ler), her kullanıcı isteği öncesinde “KV önbelleği” olarak bilinen bağlamsal bir yapı oluşturur. Bu işlem yüksek hesaplama gücü gerektirir ve giriş isteğinin uzunluğuna göre katlanarak maliyetli hale gelir. Bu nedenle, mevcut KV önbelleğini yeniden kullanmak, hesaplama yükünü ve yanıt süresini ciddi ölçüde azaltır.

Bu yaklaşım, özellikle sistem istemleri, çok adımlı sohbetler ve tekrar eden görev iş akışları gibi durumlarda büyük avantaj sağlar. Ancak hangi KV önbellek bloklarının yeniden kullanılabileceğini belirlemek için gelişmiş bir veri yönetim sistemi gerekir.

NVIDIA Dynamo Akıllı Yönlendirici, çoklu düğümlü ve ayrıştırılmış yapılara sahip geniş GPU altyapılarında KV önbellek takibi yapar. Gelen her isteği analiz eder, hash’leyerek Radix Ağacı yapısına kaydeder ve bu sayede dağıtık ortamda hangi GPU belleğinde hangi KV bloklarının bulunduğunu izleyebilir. Ardından en alakalı blokları korumak ve gereksiz olanları temizlemek için özel algoritmalar devreye girer.

Yeni bir çıkarım isteği geldiğinde, yönlendirici bu istekle GPU’larda mevcut KV blokları arasındaki örtüşme puanını (overlap score) hesaplar. Ardından bu skor ve iş yükü dağılımını göz önünde bulundurarak isteği en uygun çalışan GPU’ya yönlendirir. Böylece hem gereksiz yeniden hesaplama önlenir hem de küme genelinde dengeli bir iş dağılımı sağlanır.

Bu yöntem, geleneksel round-robin veya yalnızca yük temelli yönlendirme stratejelerinden farklıdır. Çünkü yönlendirme kararı; önbellek isabet oranı, GPU kapasitesi ve iş yükü dengesi gibi birçok faktörü değerlendirerek alınır. Bu da sistem performansını optimize eder, darboğazları ortadan kaldırır.

Sonuç olarak, KV önbelleğinin gereksiz yere yeniden hesaplanması engellenir, GPU kaynakları serbest kalır ve AI hizmet sağlayıcıları daha fazla kullanıcı isteğine, daha hızlı ve verimli şekilde yanıt verebilir. Böylece hızlandırılmış donanım yatırımlarından maksimum verim elde edilir.

Şekil 5. NVIDIA Dynamo Akıllı Yönlendirici, KV önbellek yeniden hesaplamalarını önleyerek model yanıt süresini hızlandırır ve kullanıcı deneyimini geliştirir.

NVIDIA Dynamo Dağıtık KV Önbellek Yöneticisi: Maliyet Etkin KV Saklama ve Yönetimi

Kullanıcı istekleri için KV önbelleği oluşturmak yüksek işlem gücü gerektiren ve dolayısıyla maliyetli bir süreçtir. Bu nedenle, hesaplanan KV önbelleğinin yeniden kullanılması yaygın bir optimizasyon tekniğidir. Ancak yapay zeka uygulamaları büyüdükçe, bu verilerin GPU belleğinde tutulması ciddi maliyet yükü oluşturur.

NVIDIA Dynamo KV Önbellek Yöneticisi, bu sorunu çözmek amacıyla sık erişilmeyen veya eski KV bloklarını, daha uygun maliyetli katmanlara—CPU belleği, yerel SSD’ler veya ağ bağlantılı nesne depolama çözümleri—taşır. Bu sayede GPU belleği üzerindeki yük hafiflerken, KV verileri yine de saklanarak gerektiğinde tekrar kullanılabilir hale gelir.

Bu mimariyle organizasyonlar, GPU belleğine kıyasla çok daha düşük maliyetlerle petabayt ölçeğinde KV verisini depolayabilir.

Akıllı Önbellekleme Politikaları ile Daha Fazla Verim

Dynamo, erişim sıklığına göre KV bloklarını otomatik olarak sınıflandırır:

- Sık erişilen veriler GPU belleğinde tutulur.

- Daha az erişilen veriler ise CPU belleğine, SSD’ye veya ağ üzerinden ulaşılabilen depolama katmanlarına taşınır.

Bunun yanında, sistemde akıllı silme (eviction) politikaları da devrededir. Bu politikalar, çok fazla verinin önbelleğe alınmasının yol açtığı gecikmeleri ve yetersiz önbelleklemenin neden olduğu yeniden hesaplama yükünü dengeleyerek en verimli yapılandırmayı sağlar.

Şekil 6. NVIDIA Dynamo Dağıtılmış KV Önbellek Yöneticisi, daha az sıklıkla erişilen KV önbelleğini daha ekonomik bellek hiyerarşilerine aktarır.

Büyük Ölçekli Ortamlara Uyum Sağlayan Esnek Mimari

Dynamo KV Önbellek Yöneticisi, birden fazla GPU düğümü üzerinde çalışan dağıtık ve ayrıştırılmış inference sistemlerini destekler. Aynı zamanda GPU, düğüm ve küme düzeyinde hiyerarşik boşaltma stratejileri sunarak, sistem genelinde verimli KV önbellek yönetimi sağlar. Framework bağımsız olarak tasarlanan yapı, PyTorch, SGLang, TensorRT-LLM ve vLLM gibi popüler altyapılarla tam uyumludur. Ayrıca NVIDIA NVLink, Quantum ve Spectrum anahtarları sayesinde büyük, dağıtık kümelerde ölçeklenebilirliği kolaylaştırır.

NVIDIA Inference Transfer Library (NIXL): Donanım Bağımsız, Düşük Gecikmeli Veri İletişimi

Büyük ölçekli dağıtık yapay zeka çıkarımı, tensor, pipeline ve uzman paralelliği gibi model paralelliği tekniklerini kullanır. Bu yapıların verimli çalışabilmesi için, düğümler arası ve düğüm içi yüksek bant genişliğine sahip, düşük gecikmeli iletişim gereklidir. Çoğu sistem bu ihtiyacı GPUDirect RDMA gibi teknolojilerle karşılar.

Ayrıca, ayrıştırılmış servis mimarilerinde prefill ve decode işlemlerini yürüten GPU’lar arasında KV önbelleklerin hızlı şekilde paylaşılması gerekir. Bu nedenle sistemler; CPU belleği, yerel SSD’ler ve nesne/dosya/blok depolama gibi farklı katmanlar arasında hızlı veri hareketini destekleyebilecek iletişim altyapılarına ihtiyaç duyar.

NVIDIA Inference Transfer Library (NIXL): Donanım Bağımsız, Düşük Gecikmeli Veri İletişimi

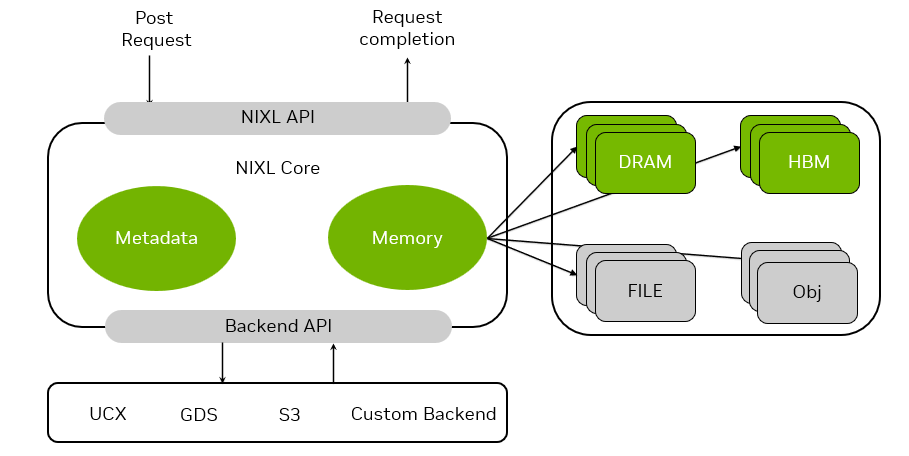

NVIDIA Inference Transfer Library (NIXL), bu gereksinimlere yönelik geliştirilmiş, yüksek bant genişlikli ve düşük gecikmeli noktadan noktaya iletişim sağlayan bir kütüphanedir. En önemli özellikleri şunlardır:

- Donanım ve ağ protokolünden bağımsızdır (NVLink, InfiniBand, RoCE, Ethernet gibi tüm protokollerle uyumlu).

- Tutarlı bir veri taşıma API’si sunar; farklı bellek ve depolama katmanları arasında verileri aynı semantiklerle asenkron şekilde taşır.

- Nonblocking ve noncontiguous veri transferlerini destekler, yani veri bütünlüğünü bozmadan performans odaklı çalışır.

- CPU belleği, SSD, blok/dosya/nesne depolama gibi çeşitli kaynaklarla çalışabilir.

- Heterojen bellek yollarını destekler ve farklı katmanlar arasında geçişi optimize eder.

NIXL ve NVIDIA Dynamo Entegrasyonu

NIXL, GPUDirect Storage, UCX ve S3 gibi farklı iletişim altyapılarına tek bir API üzerinden erişim sağlar. Bu, sistem geliştiricilerine büyük esneklik kazandırır.

NIXL ayrıca, NVIDIA Dynamo’nun politika motoru ile birlikte çalışır. Böylece, farklı kaynaklar (HBM, DRAM, yerel SSD, ağ depolama vb.) arasında en uygun arka uç (backend) bağlantısı otomatik olarak seçilir. Geliştiriciler, altyapı farklarını düşünmeden yüksek performanslı veri aktarımı gerçekleştirebilir. Bu soyutlama; tüm bellek ve depolama kaynaklarını birleştiren, genelleştirilmiş “bellek bölümleri (memory sections)” kavramı ile sağlanır.

Şekil 7. NVIDIA Çıkarım Aktarım Kütüphanesi (NIXL), heterojen bellek ve depolama aygıtları arasında veri hareketinin karmaşıklığını özetler.

Yapay Zekanın Temelinde Güçlü Hesaplama Yatıyor

Yapay zeka iş yükleriniz için en uygun donanımı seçmek, sisteminizin performansı ve verimliliği açısından kritik öneme sahiptir. İster uçtan uca kurumsal yapay zeka altyapısı için NVIDIA DGX sistemlerini, ister özel model eğitimi ve çıkarım süreçleri için yüksek performanslı ekran kartlarını incelemek isteyin, web sitemizdeki donanım çözümleri arasından ihtiyaçlarınıza en uygun seçenekleri keşfedebilirsiniz.

Ürünleri incelemek ve detaylı bilgi almak için mağazamızı ziyaret edin: https://openzeka.com/urun-kategori/sunucular/

OPENZEKA HABERLERİ

OPENZEKA HABERLERİ

Hesaplarınızda paylaşmak ister misiniz?