Üretken yapay zeka hızla gelişiyor ve her gün yeni dil modelleri (LLM – Large Language Model), görsel dil modelleri (VLM – Visual Language Model) ve görsel dil eylem modelleri (VLA – Vision Language Action) ortaya çıkıyor. Bu dönüşüm çağında öncü kalabilmek için, geliştiricilerin en yeni yapay zeka modellerini buluttan cihazlara kadar kolayca kullanabilecekleri, hızlı çalışacak şekilde optimize edilmiş ve açık makine öğrenimi araçlarıyla (CUDA kullanarak) uyumlu bir platforma ihtiyaçları var.

Jetson Orin Nano Developer Kit, performansını 1.7 kat artırıyor ve şimdi %45 daha uygun fiyatla sunuluyor. Bu güncellemeyle cihaz, Jetson Orin Nano Super Developer Kit adını alıyor. Üstelik bu geliştirme, sadece bir yazılım güncellemesiyle gerçekleştirilebiliyor.

Jetson Orin Nano Super Developer Kit

Yeni kitin sağladığı güncellemeler:

- 1.7 kat daha fazla üretken yapay zeka model performansı.

- Bir önceki 40 Sparse TOP’s değeri artık 67 sparse TOPs.

- 65 GB/s olan bellek bant genişliği artık 102 GB/s.

- 1.5 GHz olan CPU clock hızı artık 1.7 GHz.

- Maliyeti ise %45 daha az.

Aynı donanım mimarisine sahip olmasına rağmen, bu performans artışı, GPU, bellek ve CPU hızlarını artıran yeni bir güç modu sayesinde sağlanıyor. Önceki tüm Jetson Orin Nano Developer Kit modelleri, en son JetPack sürümüne yükselterek bu yeni güç modunu kullanabilir.

Bu performans artışıyla Jetson Orin Nano Super Developer Kit, generative AI (üretken yapay zeka) işlemlerinde %70’e varan bir performans artışı sunuyor. Bu, özellikle Transformer tabanlı yeni modeller gibi modern yapay zeka modellerini çalıştırmayı mümkün kılıyor. Boyutu küçük ama güçlü olan bu sistem, daha küçük modellerden 8 milyar parametreye kadar olan Llama-3.1-8B gibi büyük modellere kadar geniş bir model yelpazesini rahatlıkla çalıştırabiliyor.

Jetson, HuggingFace Transformers, Ollama, llama.cpp, vLLM, MLC ve NVIDIA TensorRT-LLM gibi makine öğrenimi (ML) framework’lerini ve optimize edilmiş çıkarım altyapısını destekler. Bu sayede bulut, edge ve PC arasında ölçeklenebilir çözümleri hızlı bir şekilde uyarlamak ve dağıtmak için ideal bir platform haline gelir.

Bu gelişmelerle hem teknik kullanıcılar hem de konuyu yeni öğrenmeye başlayanlar, modern yapay zeka modelleriyle nasıl daha verimli çalışabileceklerini keşfedebilir.

Jetson Orin Nano Super Developer Kit Özellikleri

| NVIDIA Jetson Orin Nano Developer Kit (Önceki Versiyon) | NVIDIA Jetson Orin Nano Super Developer Kit | |

|---|---|---|

| GPU | NVIDIA Ampere architecture 1,024 CUDA Cores 32 Tensor Cores 635 MHz |

NVIDIA Ampere architecture 1,024 CUDA Cores 32 Tensor Cores 1020 MHz |

| AI Performansı | 40 INT8 TOPS (Sparse) 20 INT8 TOPS (Dense) 10 FP16 TFLOPs |

67 TOPS (Sparse) 33 TOPS (Dense) 17 FP16 TFLOPs |

| CPU | 6-core Arm Cortex-A78AE v8.2 64-bit CPU 1.5 GHz |

6-core Arm Cortex-A78AE v8.2 64-bit CPU 1.7 GHz |

| Bellek | 8GB 128-bit LPDDR5 68 GB/s |

8GB 128-bit LPDDR5 102 GB/s |

| Modül Gücü | 7W | 15W | 7W | 15W | 25W |

Tablo 1. Jetson Orin Nano Super Developer Kit özellik karşılaştırması

LLM, VLM ve ViT

Jetson Orin Nano Super Developer Kit, LLM (Large Language Models), VLM (Visual Language Models) ve ViT (Vision Transformers) gibi yapay zeka modellerini çalıştırarak gömülü uygulamalarda generative AI (üretken yapay zeka) yeteneklerini kullanmak isteyenler için önemli bir performans artışı sunar.

LLM’ler, genel dil işleme ve insan benzeri metin üretimi gibi alanlarda etkili olup, özellikle doğal insan/makine etkileşimleri için NVIDIA Riva gibi akış tabanlı konuşma tanıma ve sentez sistemleriyle birleştiğinde güçlü bir araç haline gelir.

Küçük dil modelleri (SLM, <7B parametre) gibi optimizasyonlar, uç cihazlar (edge) için daha verimli hale getirilmiştir. Bu modeller, prune ve distillation gibi tekniklerle büyük modellere yakın bir performansa ulaşmış ve gerçek dünya sistemlerine bağlanabilen yapılandırılmış giriş/çıkışlarla (I/O) geliştirilmiştir.

NVIDIA NeMo gibi ML framework’lerinde desteklenen LoRA (Low-Rank Adaptation) gibi bellek dostu yöntemler, SLM’lerin uygulama bazlı alanlarda daha verimli bir şekilde özelleştirilmesini sağlamaktadır.

ViT’ler, pikselleri bölümlere ayırarak (tokenize) embedding’lere dönüştürüp görüntü işleme için Transformer mimarisini kullanır. Temel görevlerde etkili performans sergiler:

- Özellik çıkarımı (Feature extraction)

- Sınıflandırma (Classification)

- Tespit (Detection)

- Segmentasyon (Segmentation)

- Poz tahmini (Pose estimation)

Ayrıca, NVIDIA Cosmos Tokenizers gibi araçlarla 3D nokta bulutları ve video gibi daha yüksek boyutlu verilerde de kullanılabilir. Bu modeller, görsel yetenekleri açık dil desteğiyle birleştirerek farklı konular ve nesne sınıflarına dinamik sorgulamalar yapabilir.

VLM’ler, ViT ve LLM’leri birleştirerek görsel ve metinsel bilgileri aynı anda işleyebilir. Örneğin, VILA gibi modeller, görsel sahneleri detaylı bir şekilde analiz edip tanımlayabilir, nesneleri tespit edebilir ve OCR ile metin çıkarabilir. Görüntü veya video dizilerine dayalı kullanıcı sorgularını yanıtlayabilir ve uzaktan kamera akışlarının takibi gibi edge uygulamalarında kullanılabilir.

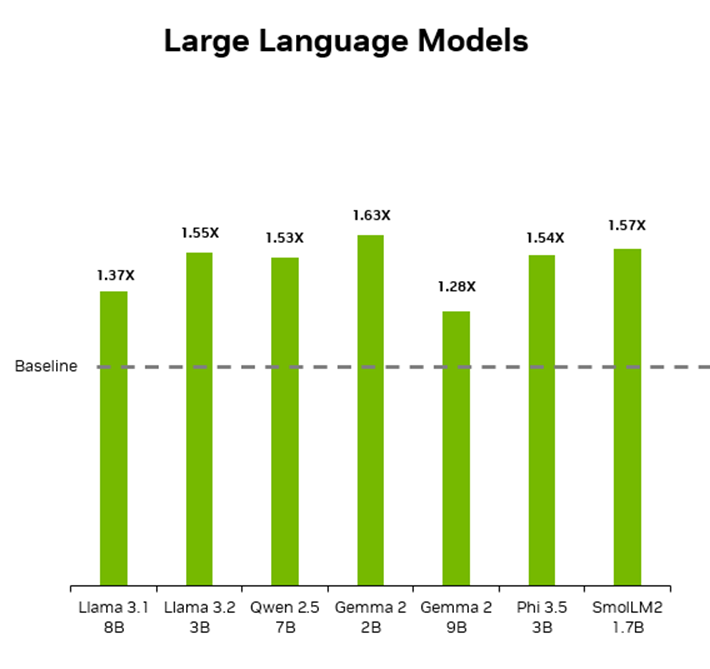

Tüm bu teknolojiler, generative AI ve multimodal sistemlerin gelişimini destekler. Jetson Orin Nano Super Developer Kit, önceki modele kıyasla bu tür modellerde önemli performans artışları sağlarken, en yeni Transformer modellerini test etmek isteyenler için kolay erişilebilirlik sağlar. Aşağıdaki testlerde, popüler olan LLM, VLM ve ViT modellerinde kaydedilen performans artışları gösterilmiştir.

Şekil 1. Jetson Orin Nano Super Developer Kit LLM performansı

| Model | Jetson Orin Nano (Önceki Sürüm) | Jetson Orin Nano Super | Performans Kazancı (X) |

|---|---|---|---|

| Llama 3.1 8B | 14 | 19.14 | 1.37 |

| Llama 3.2 3B | 27.7 | 43.07 | 1.55 |

| Qwen2.5 7B | 14.2 | 21.75 | 1.53 |

| Gemma 2 2B | 21.5 | 34.97 | 1.63 |

| Gemma 2 9B | 7.2 | 9.21 | 1.28 |

| Phi 3.5 3B | 24.7 | 38.1 | 1.54 |

| SmolLM2 | 41 | 64.5 | 1.57 |

Tablo 2. Popüler LLM modellerinin tokens\sec karşılaştırması

* MLC API kullanılarak INT4 ile LLM oluşturma performansı (saniyedeki token sayısı).

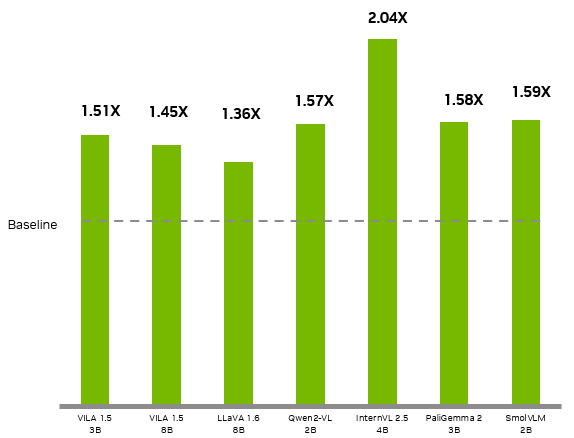

Şekil 2. NVIDIA Jetson Orin Nano Super Developer Kit VLM Karşılaştırması

| Model | Jetson Orin Nano (Önceki Sürüm) | Jetson Orin Nano Super | Performans Kazancı (X) |

|---|---|---|---|

| VILA 1.5 3B | 0.7 | 1.06 | 1.51 |

| VILA 1.5 8B | 0.574 | 0.83 | 1.45 |

| LLAVA 1.6 7B | 0.412 | 0.57 | 1.38 |

| Qwen2 VL 2B | 2.8 | 4.4 | 1.57 |

| InternVL2.5 4B | 2.5 | 5.1 | 2.04 |

| PaliGemma2 3B | 13.7 | 21.6 | 1.58 |

| SmolVLM 2B | 8.1 | 12.9 | 1.59 |

Tablo 3. Popüler VLM modellerinin tokens\sec karşılaştırması

*Tüm VILA ve LLAVA modelleri MLC kullanılarak INT4 ile çalıştırılırken geri kalan modeller Hugging Face Transformers FP4 ile çalıştırıldı.

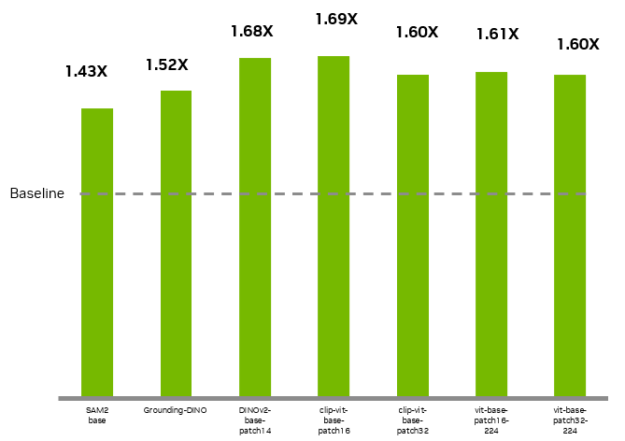

Şekil 3. Jetson Orin Nano Super Developer Kit ViT performansı

| Model | Jetson Orin Nano (Önceki Sürüm) | Jetson Orin Nano Super | Performans Kazancı (X) |

|---|---|---|---|

| clip-vit-base-patch32 | 196 | 314 | 1.60 |

| clip-vit-base-patch16 | 95 | 161 | 1.69 |

| DINOv2-base-patch14 | 75 | 126 | 1.68 |

| SAM2 base | 4.42 | 6.34 | 1.43 |

| Grounding DINO | 4.11 | 6.23 | 1.52 |

| vit-base-patch16-224 | 98 | 158 | 1.61 |

| vit-base-patch32-224 | 171 | 273 | 1.60 |

Tablo 4. Vision Transformer modellerinin tokens\sec karşılaştırması

*Tüm ViT modelleri NVIDIA TensorRT kullanılarak FP16 ile çalıştırılmıştır (ölçümler FPS cinsindendir).

Jetson Orin Nano Super Developer Kit’e Başlangıç

Performans artışından yararlanmak için JetPack SDK sayfasından SD kart imajını indirip Başlangıç Rehberi’ni takip edebilirsiniz.

NVIDIA, JetPack 6.1 tabanlı ve performans artışını destekleyen bir SD kart imajı yayınladı. Ayrıca, Jetson Orin Nano Developer Kit için SDK Manager kullanarak JetPack 6.1’i yükleyebilirsiniz. Bunun için SDK Manager’ı güncellediğinizden emin olun ve yükleme sırasında JetPack 6.1 (rev. 1) seçeneğini işaretleyin.

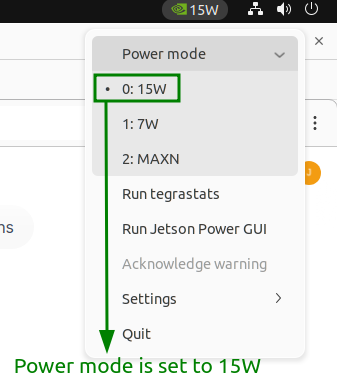

JetPack yüklendikten sonra, aşağıdaki komutla güç modunu değiştirerek performans artışını etkinleştirebilirsiniz. Mode 2 (MAXN mode), maksimum performansı sunar:

Masaüstünün üst çubuğunun sağ tarafındaki Power Mode Selector kullanarak da güç modunu değiştirebilirsiniz.

Şekil 4. Güç Modu Seçimi

Jetson Orin Nano Super Developer Kit ile generative AI (üretken yapay zeka) Deneyimi

Jetson AI Lab, bu kit üzerinde yapay zeka uygulamalarını keşfetmek isteyenler için çeşitli eğitimler ve önceden hazırlanmış yazılım paketleri sunuyor. Robotik alanına ilgi duyuyorsanız, LeRobot eğitimine göz atabilirsiniz. Ayrıca, generative AI tabanlı bir sohbet robotu oluşturmak isteyenler için özel bir rehber de bulunuyor.

Hugging Face LeRobot

NVIDIA, LeRobot açık yapay zeka platformunda robotik araştırmaları hızlandırmak için Hugging Face ile iş birliği yaptı. Jetson Orin Nano Super Developer Kit üzerinde Hugging Face LeRobot’u çalıştırabilirsiniz. Bu platform, görsel veriler ve önceki hareket bilgilerini kullanarak belirli bir görev için gerekli eylemleri tahmin eden generative AI modellerini destekler.

Şekil 5. Jetson Orin Nano Developer Kit Kullanan Hugging Face LeRobot

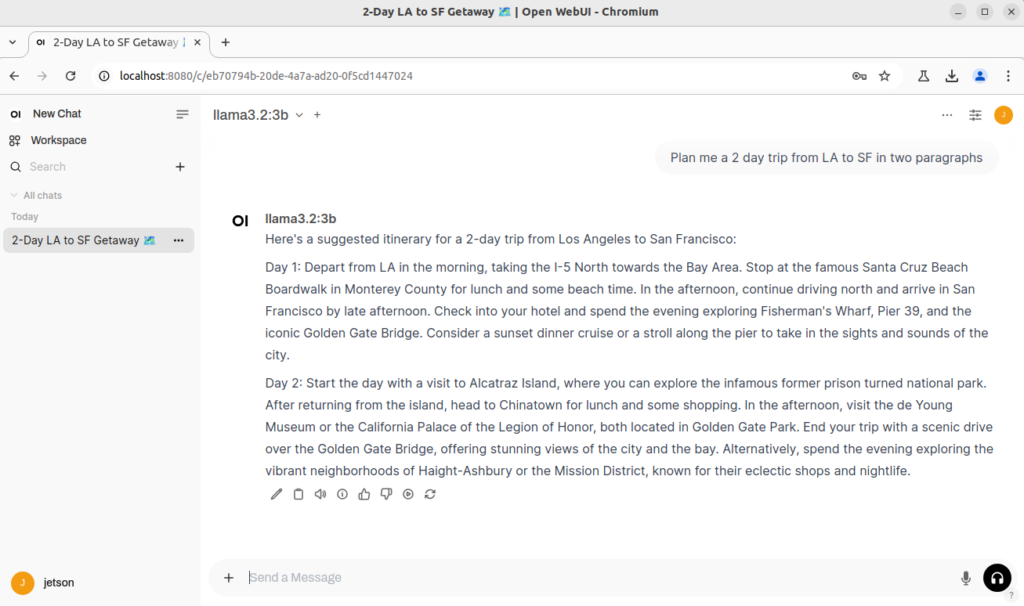

Ollama ile Generative AI Destekli Chatbot

Jetson Orin Nano Super Developer Kit üzerinde generative AI tabanlı bir sohbet robotu çalıştırabilirsiniz. Bu sohbet robotu, açık kaynaklı ve yaygın olarak kullanılan bir sohbet sunucu arayüzü olan Ollama with Open WebUI kullanır. Sistem, yerel olarak çalışan LLM’lere (Large Language Models) bağlanır ve kullanıcı deneyimini geliştirmek için retrieval-augmented generation (RAG) yöntemini kullanır. Bu yöntem, daha etkili ve kapsamlı cevaplar sunmak için verileri modelle birleştirir.

Şekil 6. Jetson Orin Nano Super Developer Kit Üzerinde Çalışan Generative AI Chatbot

Jetson AI Lab ile İleri Seviye Generative AI

Jetson AI Lab, edge cihazlar için optimize edilmiş en yeni generative AI (üretken yapay zeka) teknolojilerini keşfetmek ve denemek için bir merkezdir.

NVIDIA, açık kaynaklı edge yapay zeka ve robot öğrenimi alanında ilerleme sağlamak için geliştiriciler ve iş ortaklarıyla birlikte çalışarak topluluk odaklı bir ortam sunar. Jetson cihazlarında popüler makine öğrenimi framework’leri ve optimize edilmiş çıkarım mikro hizmetleri için kapsamlı destek sayesinde, en son araştırma yeniliklerini ve modellerini hızla geliştirebilir ve uygulayabilirsiniz.

Şekil 7, NanoOWL açık kelime dağarcıklı gerçek zamanlı nesne algılama ViT (Vision Transformer) örneklerini göstermektedir.

Şekil 7. Gerçek Zamanlı Nesne Takibi Demosu

Şekil 8, NanoDB adlı multimodal vektör veritabanını ve bu veritabanıyla yapılan txt2img (metinden görüntüye) ve img2img (görüntüden görüntüye) benzerlik aramalarını göstermektedir. Bu özellikler, farklı veri türleri arasında etkileşimli ve sezgisel bir arama deneyimi sunar.

Şekil 8. Benzer Görsel Arama Örneği

Jetson AI Lab, her deneyim seviyesindeki geliştiriciler için kolayca takip edilebilen yaklaşık 50 eğitim ve önceden hazırlanmış yazılım paketleri sunar. Bu içerikler, yerel cihazlarda çalışan LLM’ler (Large Language Models), SLM’ler (Small Language Models), VLM’ler (Visual Language Models) ve VLA’lar (Vision Language Actions) gibi multimodal yapay zeka modellerini kullanıma hazır hale getirir. Ayrıca diffusion policies ve ses modelleri için de farklı seçenekler sunar. Tüm bu modeller, bulutta kullanılan aynı optimize edilmiş çıkarım altyapısı ile yerel olarak çalıştırılır.

Jetson AI Lab’in iş birliğine dayalı ve topluluk odaklı eğitimleri, gelişmiş yapay zeka teknolojilerini uç cihazlara taşımayı çok daha erişilebilir hale getirir.

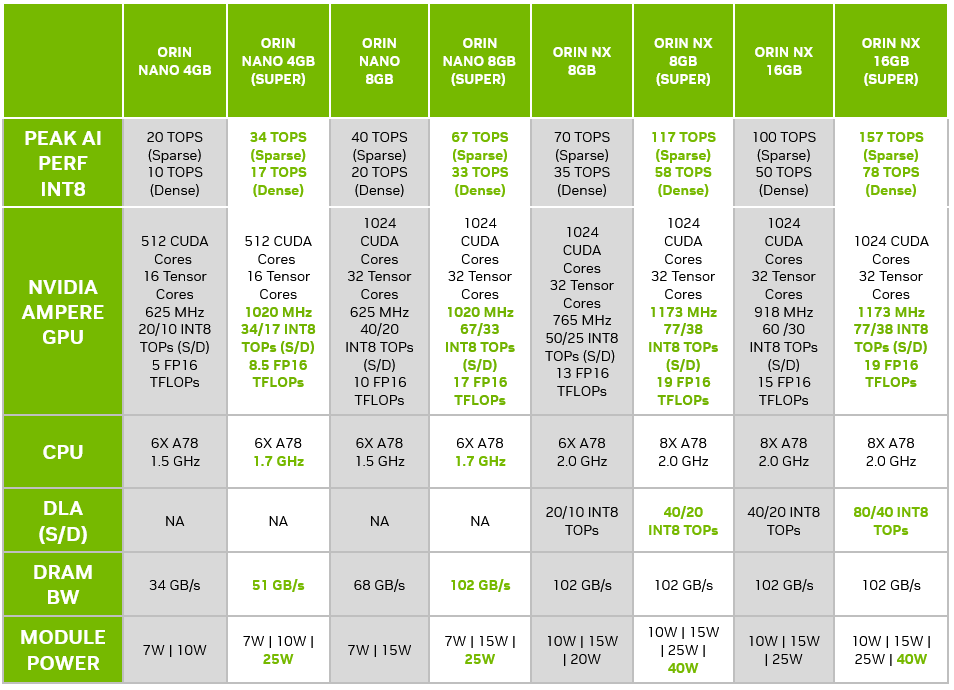

Bütün Jetson Orin Nano ve Orin NX Serileri Performans Geliştirmesine Sahip Oluyor

NVIDIA, Jetson Orin Nano ve Jetson Orin NX serilerindeki performansı da yeniliyor. Küçük yapay zeka kameralarından büyük otonom makinelere kadar, her uç cihazı, generative AI modellerini çalıştırmak için yeterli işlem gücüne ihtiyaç duyuyor.

Aynı donanım modülleriyle, farklı modellerde %70’e kadar performans artışı elde edebilirsiniz:

- Orin Nano serisi: GPU, CPU ve bellek hızlarında yapılan iyileştirmelerle performans artışı sağlanıyor.

- Orin NX serisi: GPU ve DLA (Deep Learning Accelerator) performansında geliştirmeler yapıldı.

Bu güncellemeler, mevcut donanımınızla daha yüksek verim almanızı mümkün kılar.

Tablo 5. Jetson Orin Nano Super ve Orin NX Super modül özellikleri

Jetson Orin Nano ve Orin NX üretim modüllerindeki performans artışı için destek ve dokümantasyon, Ocak ayının ilk yarısında JetPack 6.1.1 ile yayınlanacak.

Artan müşteri talebi nedeniyle NVIDIA, Jetson Orin ürün serisinin ürün yaşam döngüsünü 2032’ye kadar uzattığını duyurdu. Bu performans artışı sayesinde Orin Nano ve Orin NX serileri, hem mevcut hem de gelecekteki modeller için ideal platformlar olarak öne çıkıyor.

OPENZEKA HABERLERİ

OPENZEKA HABERLERİ

Hesaplarınızda paylaşmak ister misiniz?