Son yıllarda yapay zeka alanında adeta bir devrim yaşanıyor. GPT, LLaMA, Claude gibi büyük dil modelleri (LLM – Large Language Models), artık yalnızca akademik araştırmalarda değil; iş dünyasından gündelik yaşama kadar pek çok alanda karşımıza çıkıyor. Metin üretiminden görsel oluşturmaya, yazılım geliştirmeden ilaç keşfine kadar geniş bir yelpazede kullanılan bu modeller, müşteri hizmetlerinde otomasyon sağlayan AI agent’lardan kurumsal iş akışlarını yöneten yapay zekâ destekli asistanlara kadar uzanan yepyeni kullanım senaryolarını da beraberinde getiriyor.

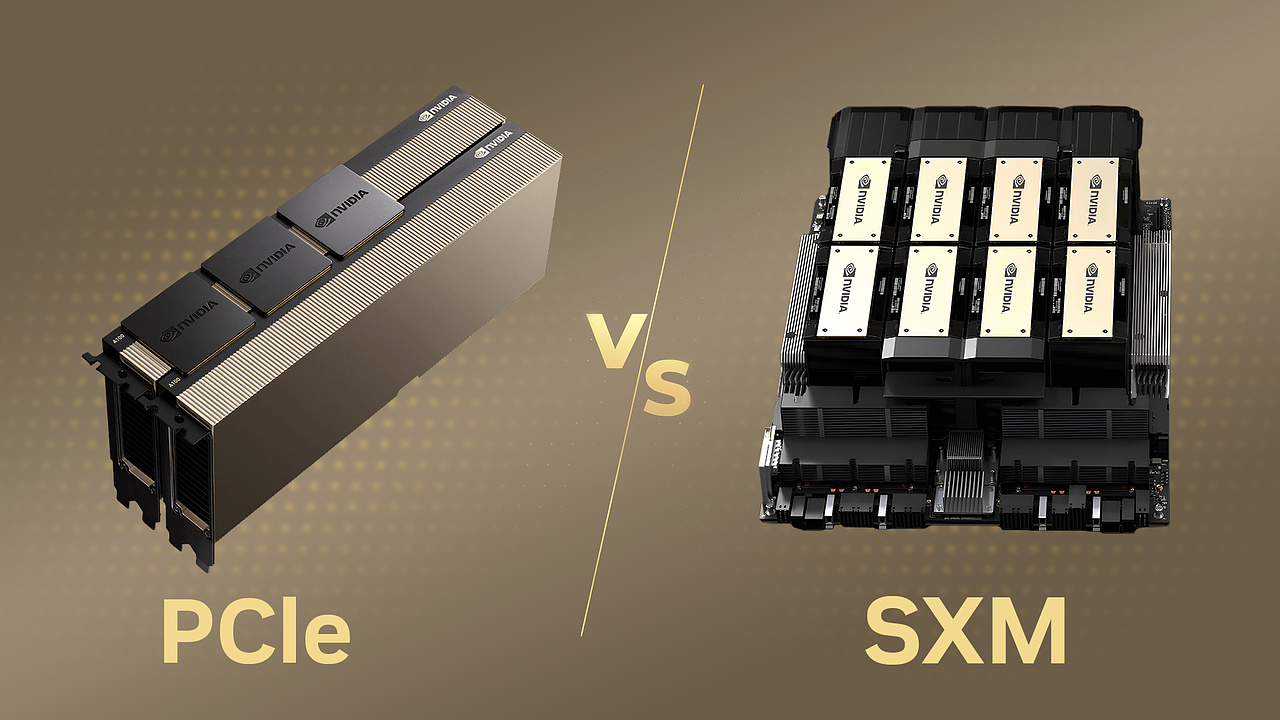

Bu dönüşümün ortak noktası ise tek bir kavramda birleşiyor: hesaplama gücü. Milyonlarca, hatta milyarlarca parametreyi işleyebilen bu modellerin arkasında, devasa bir donanım altyapısı bulunuyor. Dolayısıyla yapay zekadan faydalanmak isteyen kurumlar, şirketler ve araştırmacılar için kritik bir soru gündeme geliyor: “Yapay zeka uygulamalarımız için hangi donanım altyapısını tercih etmeliyiz?” Özellikle yapay zeka ve veri yoğun iş yükleri için sunucu yatırımı planlayan firmalar açısından, en önemli karar noktası tercih edilecek GPU tabanlı donanım mimarisidir. İşte bu noktada NVIDIA’nın iki temel sunucu çözümü öne çıkıyor: SXM ve PCIe.

SXM Nedir?

SXM (Server eXtended Module), NVIDIA’nın yüksek performanslı sunucu GPU’ları için geliştirdiği özel bir soket mimarisidir. Geleneksel PCIe kart yapısından farklı olarak GPU, anakarta doğrudan yerleştirilen özel bir yuva üzerinden bağlanır.

SXM’in en önemli avantajı, GPU’lar arası iletişimde NVLink ve NVSwitch teknolojilerini kullanmasıdır. Bu sayede çoklu GPU yapılandırmalarında cihazlar, adeta tek bir birleşik GPU gibi çalışır ve yüzlerce GB/s seviyesinde bant genişliğiyle veri paylaşabilir. Böylelikle büyük ölçekli yapay zekâ eğitimi ve yüksek performanslı hesaplama (HPC) senaryolarında darboğazlar minimuma iner.

Örneğin, bir H200 NVL GPU 141 GB vRAM kapasitesine sahiptir. SXM tabanlı, 8 GPU’lu bir sunucuda bu kapasite 8 × 141 = 1128 GB seviyesine ulaşarak devasa bir birleşik ekran kartı elde edilir. Özellikle büyük yapay zeka modellerinin eğitiminde GPU bellek kapasitesi en kritik darboğazlardan biridir ve SXM bu sorunu büyük ölçüde hafifletir.

NVIDIA’nın DGX ve HGX platformlarında standart olarak kullanılan SXM mimarisi, maksimum performans, yüksek ölçeklenebilirlik ve GPU’lar arası sıkı entegrasyon gerektiren kurumsal ve araştırma odaklı iş yüklerinde öne çıkmaktadır.

SXM tabanlı ürünleri inceleyin: https://openzeka.com/urun-etiketi/sxm/

PCIe Nedir?

PCIe (Peripheral Component Interconnect Express), aslında kullanıcılara en tanıdık gelen form faktördür. GPU’lar, anakart üzerindeki standart PCIe yuvalarına kart şeklinde takılır ve bu sayede kolay entegrasyon imkânı sunar.

PCIe tabanlı GPU’ların en büyük avantajı, esneklik ve geniş uyumluluk sağlamalarıdır. Hemen her sunucu altyapısında PCIe yuvaları bulunduğu için, bu GPU’lar çok geniş bir ekosistemde rahatlıkla kullanılabilir. Ancak GPU’lar arası iletişim söz konusu olduğunda SXM’in sunduğu hız ve bant genişliği seviyesine ulaşılamaz; zira bu yapılandırmalarda NVLink yerine PCIe veri yolu üzerinden bağlantı sağlanır.

PCI tabanlı ürünleri inceleyin: https://openzeka.com/urun-kategori/sunucular/pcie/

Hangi Durumda Hangi Mimariyi Seçmeliyim?

Mimari tercihlerde “SXM daha iyidir” veya “PCIe kötüdür” gibi genellemelerdense, esas olan kullanım amacınızı doğru belirlemektir. SXM mimarili bir yapı, bazı kullanım senaryoları için gereğinden fazla (overkill) olabilir ve projeniz açısından maliyet etkin bir çözüm sunmayabilir. Diğer yandan, GPU’lar arasında yüksek haberleşme hızına ihtiyaç duyduğunuz bir durumda yalnızca başlangıç maliyeti daha düşük olduğu için PCIe mimarisini tercih etmeniz, model eğitimi sırasında ciddi zaman kayıplarına ve dolayısıyla toplam maliyetin artmasına neden olabilir. Bu nedenle, doğru mimari seçiminin temeli kullanım senaryonuzun ve gereksinimlerinizin doğru analizine dayanır. Bu analiz, yatırımınızın verimliliğini belirleyen en kritik faktördür.

SXM’i Tercih Etmeniz Gereken Durumlar

SXM mimarisi, yüksek bellek bant genişliği ve GPU’lar arası düşük gecikmeli iletişim avantajları sayesinde çoklu GPU koordinasyonu gerektiren senaryolarda öne çıkar. Aşağıdaki durumlarda SXM yapısı tercih edilmelidir:

- Büyük Dil Modelleri (LLM) veya Derin Öğrenme Eğitimi:

Milyarlarca parametre içeren modellerin eğitimi sırasında, GPU’lar arasında yüksek hızda veri paylaşımı gerekir. SXM mimarisi, NVLink/NVSwitch bağlantıları sayesinde bu iletişimi PCIe’ye göre katbekat daha hızlı sağlar. - Modelinizin Birden Fazla GPU’yu Eş Zamanlı Kullanması Gerekiyorsa:

Özellikle model paralelliği (model parallelism) veya pipeline parallelism gibi tekniklerde, bir modelin farklı katmanları birden fazla GPU’ya dağıtılır. Bu durumda GPU’lar arası senkronizasyon hızı kritik hale gelir; SXM bu tür iş yükleri için idealdir. - Fine-Tuning veya Devam Eğitimi (Continual Learning):

Önceden eğitilmiş modeller üzerinde yeniden eğitim yaparken (örneğin LLaMA veya GPT tabanlı modellerin kurumsal veriyle uyarlanması), GPU bellek kapasitesi ve hızlı haberleşme performansı büyük avantaj sağlar. - HPC (High Performance Computing) Uygulamaları:

İklim simülasyonu, moleküler dinamik, CFD (Computational Fluid Dynamics), kuantum hesaplama veya fiziksel modelleme gibi uygulamalarda GPU’lar arası koordinasyon kritik öneme sahiptir.

- Yüksek Bellek Kapasitesi Gereksinimi Olan Modeller:

Örneğin H200 veya H100 GPU’ların SXM sürümleri, PCIe eşdeğerlerine göre daha fazla HBM3 bellek kapasitesine sahiptir. Bu da büyük batch boyutlarıyla eğitim yapmayı veya daha karmaşık modelleri belleğe sığdırmayı kolaylaştırır. - Zamanın Kritik Olduğu Eğitim Senaryoları:

Modelinizi olabildiğince kısa sürede eğitmek istiyorsanız, SXM’in daha yüksek güç sınırları (TDP) ve dolayısıyla daha yüksek ham performansı ciddi bir avantaj sağlar

PCIe’yi Tercih Etmeniz Gereken Durumlar

PCIe mimarisi, esneklik, uyumluluk ve maliyet etkinliği ile öne çıkar. Bu yapı, donanım altyapısı çeşitliliği yüksek olan veya yoğun eğitimden ziyade çıkarım (inference) süreçlerine odaklanan kurumlar için idealdir.

- Yapay Zeka Çıkarımı (Inference) veya Küçük Modellerle Çalışma:

Eğitimini tamamlamış modelleri (örneğin BERT, Whisper, Stable Diffusion vb.) üretim ortamında çalıştırmak için PCIe GPU’lar genellikle yeterlidir. Bu senaryolarda GPU’lar arası iletişim yükü düşük olduğu için SXM avantajı belirgin değildir.

- Fine-Tuning veya Transfer Learning’in Küçük Ölçekli Olduğu Durumlar:

Küçük boyutlu modeller (örneğin 7B–13B parametre) üzerinde kısıtlı veriyle ince ayar yapıyorsanız, PCIe GPU’lar maliyet açısından daha uygundur. - Var Olan Sunucu Altyapınıza GPU Eklemek İstiyorsanız:

PCIe form faktörü, hemen her modern sunucu ile uyumludur. Bu sayede mevcut sistemlere GPU eklemek kolay ve ekonomik bir çözümdür. - Edge veya On-Premise Dağıtık Kullanım Senaryoları:

Veri merkezine bağlı kalmadan lokal inference (ör. üretim hattı izleme, güvenlik kameraları, edge analytics) yapmak istiyorsanız, PCIe tabanlı sistemler enerji verimliliği ve entegrasyon kolaylığı açısından avantajlıdır. - Karma İş Yükleri (Mixed Workloads):

Aynı sunucuda hem CPU ağırlıklı hem de GPU tabanlı görevleri (ör. veri işleme + inference) bir arada yürütmek istiyorsanız, PCIe yapısı bu tür hibrit iş yüklerine daha esnek uyum sağlar. - Maliyet, Enerji Verimliliği ve Soğutma Önceliğinizse:

H200 PCIe sürümü, genellikle 400–450W aralığında güç tüketimine sahiptir ve hava soğutma ile çalışabilir. Bu da onu SXM versiyonuna göre enerji verimliliği ve soğutma altyapısı gereksinimleri açısından daha avantajlı hale getirir. Ayrıca daha düşük toplam sahip olma maliyeti (TCO) ile, maliyet-duyarlı projelerde tercih edilen bir seçenektir.

Sonuç

Yapay zeka, derin öğrenme ve yüksek performanslı hesaplama (HPC) dünyasında başarı; yalnızca güçlü algoritmalarla değil, bu algoritmaları çalıştıracak doğru donanım mimarisini seçmekle mümkündür. Bu bağlamda NVIDIA’nın SXM ve PCIe çözümleri, farklı ihtiyaçlara hitap eden iki güçlü yaklaşım sunar. SXM mimarisi, maksimum performans, GPU’lar arası yüksek hızlı haberleşme ve büyük ölçekli paralel eğitim senaryoları için tasarlanmıştır. NVLink ve NVSwitch teknolojileri sayesinde SXM tabanlı sistemler, çoklu GPU’yu tek bir devasa işlem birimi gibi çalıştırabilir. Bu da onları LLM eğitimi, model paralelliği, HPC uygulamaları veya yüksek bellek gerektiren deep learning görevleri için vazgeçilmez hale getirir. Ancak bu üstün performans; daha yüksek güç tüketimi (ör. H200 SXM için ~700W) ve daha yüksek donanım maliyeti gibi faktörlerle birlikte gelir. Dolayısıyla SXM, her zaman “en iyi” değil, doğru senaryo için en uygun seçenektir.

Diğer yandan PCIe mimarisi, esneklik, geniş uyumluluk ve maliyet etkinliği ile öne çıkar. H200 PCIe sürümleri (~400–450W) daha düşük güç tüketir, hava soğutma ile çalışabilir ve mevcut sunucu altyapılarına kolayca entegre edilebilir. Bu yönüyle PCIe GPU’lar, inference (çıkarım) işlemleri, küçük ölçekli fine-tuning, edge/dağıtık uygulamalar veya karma iş yükleri için ideal çözümdür.Enerji verimliliği, TCO (Toplam Sahip Olma Maliyeti) ve ölçeklenebilirlik öncelikli kurumlarda PCIe sistemleri, uzun vadede daha dengeli bir yatırım sunar.

Özetle; eğer performans, ölçeklenebilirlik ve eğitim süresinde maksimum verim sizin önceliğinizse, SXM mimarili bir yapı kaçınılmaz tercihtir.

Ancak maliyet etkinliği, esneklik, mevcut sistemlerle uyum ve enerji verimliliği sizin için daha önemliyse, PCIe mimarisi çok daha rasyonel bir çözümdür.

Gerçek anlamda doğru seçim, donanım mimarisinin değil; iş yükünüzün, modelinizin ve hedeflerinizin analizine dayanır. Yatırım kararınızı verirken performans, ölçeklenebilirlik, enerji, soğutma ve toplam sahip olma maliyetini birlikte değerlendirmeniz; yapay zeka altyapınızın geleceğe hazır, sürdürülebilir ve verimli olmasını sağlayacaktır.

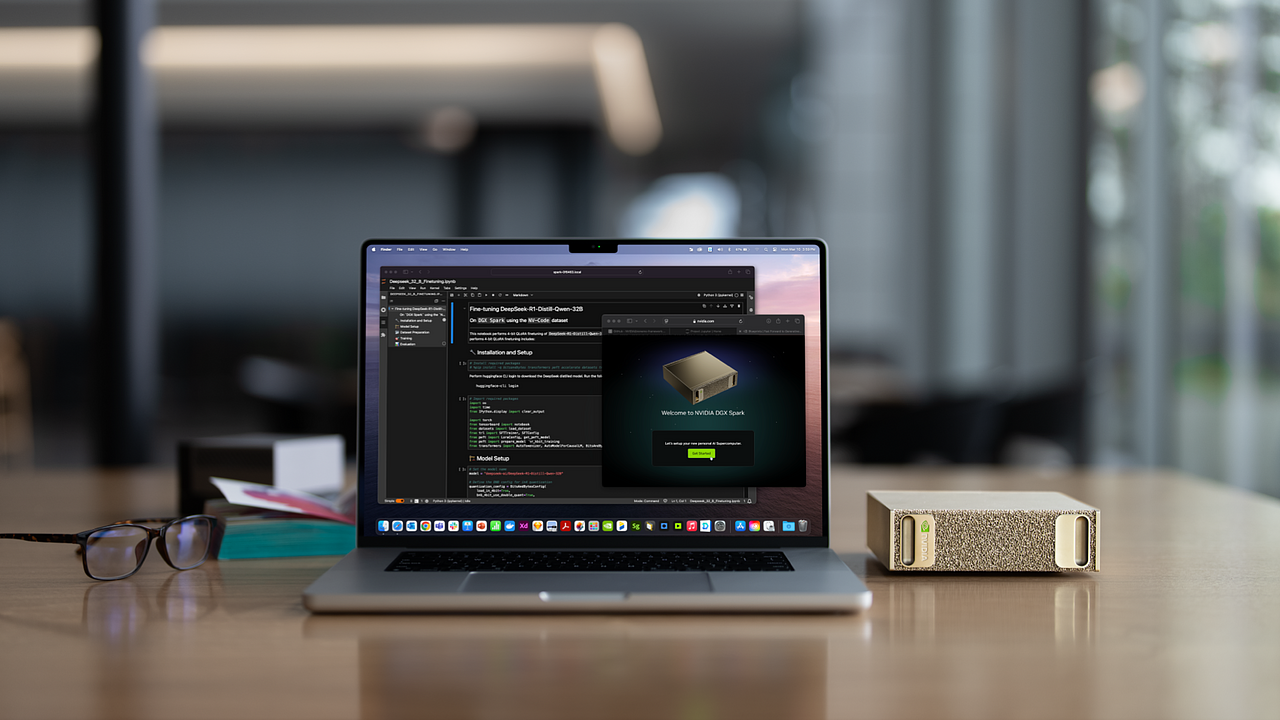

OpenZeka olarak, NVIDIA’nın sunduğu en yeni ve güçlü hesaplama altyapısını kullanıcılarla buluşturuyor; ihtiyaçlarınıza özel donanım çözümleri, optimize altyapı yönetimi ve iş yükü orkestrasyonu sağlıyoruz.

İster düşük/orta seviye sunucu ihtiyacınız olsun, ister kurumsal düzeyde NVIDIA DGX POD çözümlerine ihtiyaç duyun, NVIDIA® DGX AI Compute Systems partneri olarak, anahtar teslim çözümlerle yanınızdayız.

Ürünleri incelemek ve detaylı bilgi almak için mağazamızı ziyaret edin: https://openzeka.com/urun-kategori/sunucular/

OPENZEKA HABERLERİ

OPENZEKA HABERLERİ

Hesaplarınızda paylaşmak ister misiniz?