NVIDIA, geçtiğimiz ay düzenlenen Supercomputing 2024 Konferansı’nda, en yeni NVIDIA Hopper platformu olan NVIDIA H200 NVL‘nin kullanıma sunulduğunu duyurdu. Kurumsal iş yükleri için optimize edilen NVIDIA H200 NVL, geniş bir yelpazedeki yapay zeka (AI) ve yüksek performanslı hesaplama (HPC) uygulamaları için hızlandırılmış performans sunan çok yönlü bir platformdur. Çift yuvalı PCIe form faktörü ve 600W TGP ile H200 NVL, daha düşük güçlü, hava soğutmalı raf tasarımları için esnek yapılandırma seçenekleri sağlar.

NVIDIA H200 NVL ile Kurumsal Sunucular İçin Yapay Zeka Hızlandırma

NVIDIA H200 NVL, müşteri hizmetleri için yapay zeka ajanları, güvenlik açığı tespiti, finansal dolandırıcılık analizi, sağlık araştırmaları ve sismik analiz gibi AI ve HPC iş yüklerinin geliştirilmesi ve dağıtılması için tasarlanmış bir platformdur. H200 NVL, kurumsal sunucular için AI hızlandırmayı bir üst seviyeye taşıyarak, büyük dil modelleri (LLM) çıkarımında 1.7 kat, HPC uygulamalarında ise 1.3 kat daha yüksek performans sunar.

H200 NVL’nin sunduğu yeniliklere daha detaylı bakacak olursak:

Geliştirilmiş Bellek

H200 NVL, H100 NVL ile aynı mimariyi kullanmakla birlikte (Hopper), 141 GB HBM3e ile bellek kapasitesi ve bant genişliğinde önemli bir yükseltme sağlar. Bu, H100 NVL’ye kıyasla bellek kapasitesinde 1.5 kat, bant genişliğinde ise 1.4 kat artış anlamına gelir.

Bu iyileştirmeler sayesinde, daha büyük modeller tek bir GPU’ya sığabilir ve veriler daha hızlı taşınır. Bunun sonucunda, daha yüksek işleme kapasitesi ve saniye başına daha fazla token elde edilir. Daha büyük bellek kapasitesi, aynı GPU üzerinde birden fazla ayrı iş yükünü çalıştırmak için daha büyük MIG (multi-insance GPU) bölümleri oluşturmanıza da olanak tanır.

Yeni NVLink Özellikleri

H200 NVL, yeni bir 4 yönlü NVLink ara bağlantısını destekleyerek 1.8 TB/sn bant genişliği ve 564 GB birleşik HBM3e belleği sunar. Bu, H100 NVL’nin 2 yönlü NVLink yapılandırmasına kıyasla 3 kat daha fazla bellek sağlar.

Ayrıca H200 NVL, 2 yönlü NVLink köprüsü ile eşleştirilebilir ve GPU’lar arası 900 GB/sn’lik ara bağlantı bant genişliği sağlar. Bu, H100 NVL’ye göre %50, PCIe Gen5’e göre ise 7 kat daha hızlıdır.

| Özellik | NVIDIA H100 NVL | NVIDIA H200 NVL | İyileştirmeler |

|---|---|---|---|

| Bellek | 94GB HBM3 | 141GB HBM3e | 1.5x bellek kapasitesi |

| Bellek Bant Genişliği | 3.35 TB/s | 4.8 TB/s | 1.4x hızlı |

| Maximum NVLink (BW) | 2-yol (600 GB/s) | 4-yol (1.8 TB/s) | 3x hızlı |

| Maximum Memory Pool | 188 GB | 564GB | 3x geniş |

Tablo1: H100 NVL ve H200 NVL özellik kıyaslama tablosu

NVIDIA AI Enterprise Lisansı Dahil

H200 NVL, NVIDIA AI Enterprise için 5 yıllık abonelik lisansı ile birlikte gelir. Bu bulut tabanlı yazılım platformu, kurumsal düzeyde yapay zeka uygulamalarının geliştirilmesini ve dağıtımını kolaylaştırmak için kapsamlı araçlar, framework’ler, SDK’lar ve NVIDIA NIM mikro hizmetlerini (daha detaylı bilgi için bakınız: NVIDIA NIM) sunar.

NVIDIA NIM çıkarım mikro hizmetleri ve NVIDIA Blueprints erişimi ile NVIDIA AI Enterprise’ın gücü, H200 NVL ile birleşerek özel yapay zeka uygulamalarını en hızlı şekilde geliştirme ve operasyonel hale getirme olanağı sağlar. Bu süreçte, model performansını en üst düzeyde tutmayı da garanti eder.

H200 NVL için Önerilen Yapılandırma

NVIDIA Enterprise Referans Mimarisi programı, kısa süre önce H200 NVL’yi kapsayacak şekilde genişletildi. Her NVIDIA Enterprise Referans Mimarisi, yüksek performanslı, ölçeklenebilir ve güvenli hızlandırılmış hesaplama altyapısı oluşturmak için donanım ve yazılım önerilerinin tam bir yığını ile gelir. Ayrıca modern yapay zeka iş yükleri için sunucu, küme ve ağ yapılandırmalarına yönelik ayrıntılı kılavuzlar içerir.

Her bir Enterprise Referans Mimarisi’nin merkezinde, bir küme ortamında dağıtıldığında en iyi performansı sağlamak için optimize edilmiş NVIDIA Sertifikalı Sistem sunucusu bulunur. Bu sunucular, belirli bir tasarım modeline göre oluşturulmuştur. Şu anda Enterprise Referans Mimarisi’nin tasarlandığı üç tür sunucu yapılandırması bulunmaktadır:

NVIDIA Base Command

NVIDIA Base Command, DGX platformunu güçlendirerek şirketlerin NVIDIA yazılım inovasyonlarından tam anlamıyla yararlanmasını sağlar. İşletmeler, kurumsal düzeyde düzenleme ve küme yönetimi, hesaplama, depolama ve ağ altyapısını hızlandıran kütüphaneler ve yapay zeka iş yükleri için optimize edilmiş bir işletim sistemi içeren bu platformla DGX altyapılarının tüm potansiyelini açığa çıkarabilir. Ayrıca, DGX altyapısı, yapay zeka geliştirme ve dağıtım süreçlerini kolaylaştırmak için optimize edilmiş yazılım paketleri sunan NVIDIA AI Enterprise ile birlikte gelmektedir.

- PCIe Optimize Edilmiş 2-4-3,

- PCIe Optimize Edilmiş 2-8-5,

- HGX Sistemleri.

- PCIe Optimize Edilmiş yapılandırmalar için (örneğin, 2-8-5), rakamlar sırasıyla CPU soket sayısını, GPU sayısını ve ağ adaptörü sayısını ifade eder.

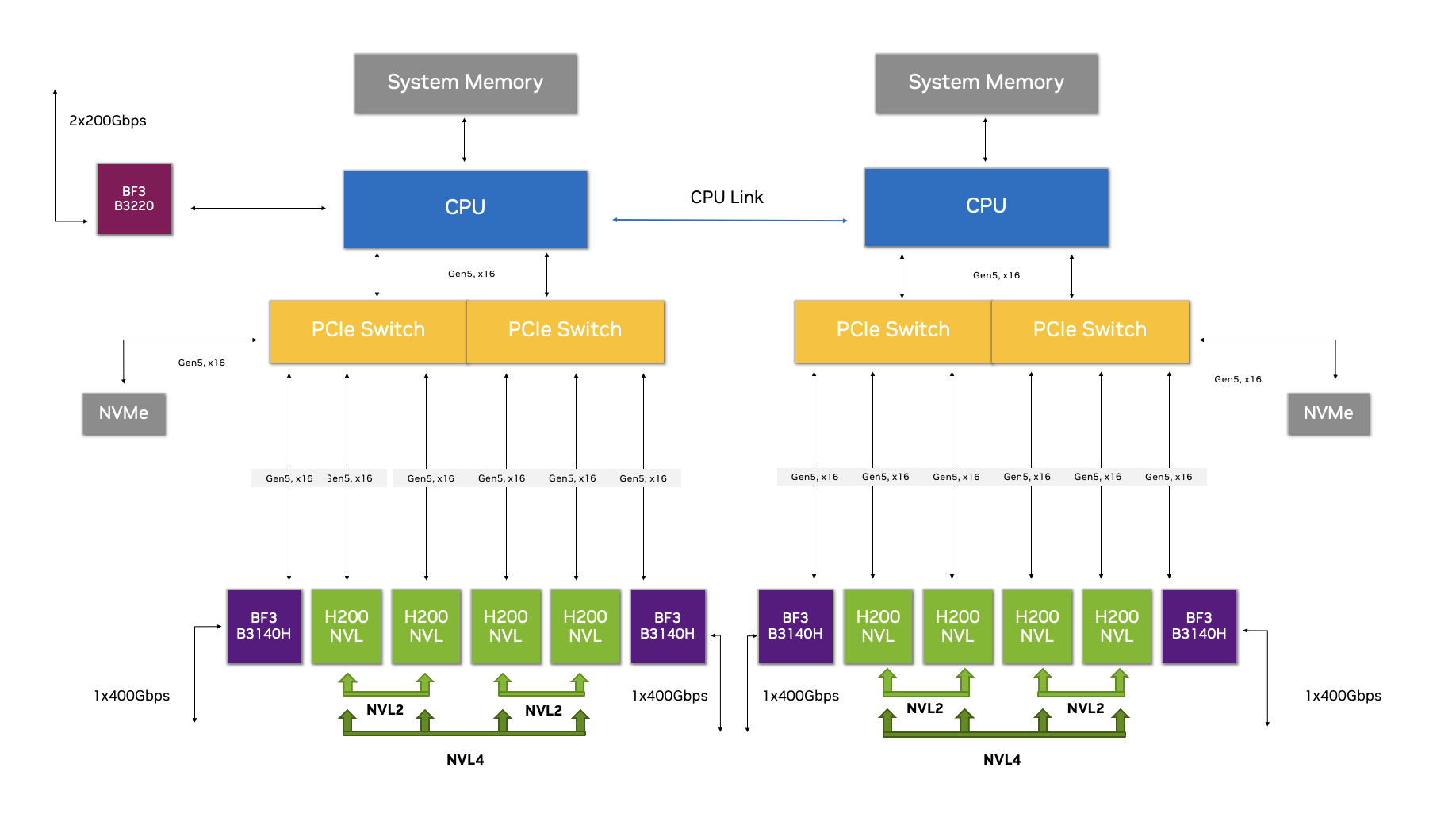

H200 NVL için NVIDIA Enterprise Referans Mimarisi PCIe Optimize Edilmiş 2-8-5 referans yapılandırmasını kullanır.

Şekil 1. NVIDIA H200 NVL ile PCIe Optimized 2-8-5 yapılandırması

Bu Yapılandırmanın Özgünlüğü Nedir?

H200 NVL ile PCIe Optimize Edilmiş 2-8-5 yapılandırması, düşük gecikme süresi, daha az CPU kullanımı ve ağ bant genişliğinin artırılması sayesinde, verimli veri işleme gerektiren gerçek zamanlı işlemler için optimize edilmiştir. Bu yapılandırma, GPU’lar arasında maksimum iletişim sağlamak için birden fazla veri aktarım yolu oluşturarak bu başarıyı elde eder.

Birinci Veri Aktarım Yolu: NVLink

NVLink, aynı bellek alanındaki GPU’lar arasında yüksek hızlı ve düşük gecikmeli iletişim sağlamak için bir bağlantı köprüsü oluşturur.

İkinci Veri Aktarım Yolu: NVIDIA Spectrum-X Ethernet Ağları

Spectrum-X, RoCE (Remote Direct Memory Access) entegrasyonu ile GPU’lar arasında düşük gecikmeli ve verimli bir iletişim yolu sunar. Bu ağlar, küme içindeki GPU’lar arasında doğrudan bellek erişimini mümkün kılar.

Etkili Veri Hareketi ile Performans Artışı

H200 NVL’nin 4-yollu NVLink özelliği, bu optimize edilmiş yapılandırma ile birleştiğinde, veri hareketinde eşi görülmemiş bir verimlilik sağlar. İster NVLink yoluyla ister Spectrum-X ve RoCE ile olsun, sunucu ve küme içindeki GPU’lar arasındaki iletişim, CPU ve PCIe veriyolunu atlayarak gerçekleşir. Bu da daha az yük, daha yüksek veri aktarım hızı ve daha düşük gecikme süresi anlamına gelir.

NVIDIA GPUDirect Teknolojisi

NVIDIA GPUDirect, ağ adaptörlerinin ve depolama sürücülerinin GPU belleğine doğrudan okuma ve yazma yapmasını sağlayarak CPU üzerindeki yükü azaltır. GPUDirect şu özellikleri kapsayan kapsamlı bir API seti sunar:

- GPUDirect Storage

- GPUDirect Remote Direct Memory Access

- GPUDirect Peer to Peer (P2P)

- GPUDirect VideoBu API’ler, gecikmeyi azaltmak ve performansı artırmak üzere tasarlanmıştır.

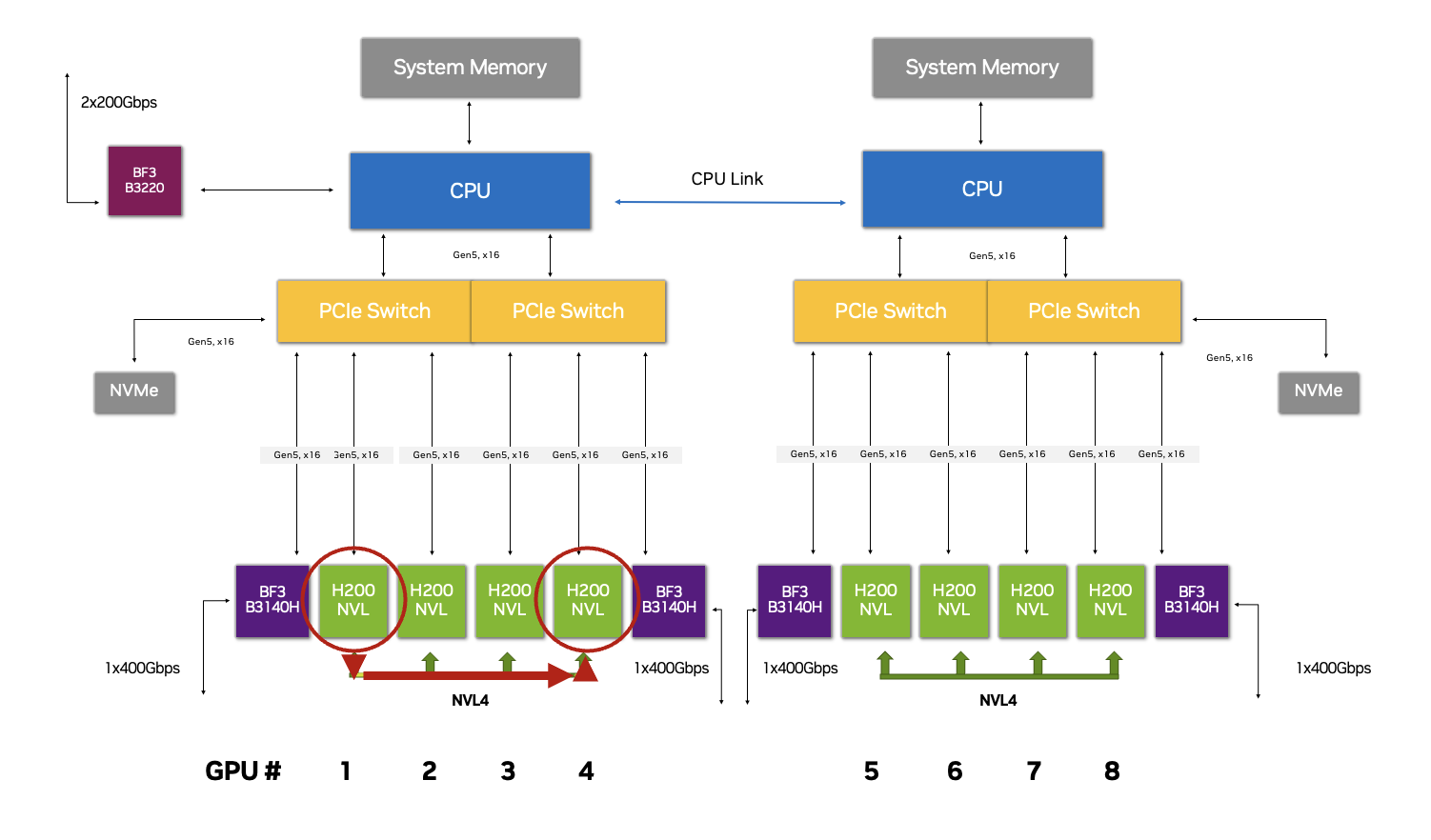

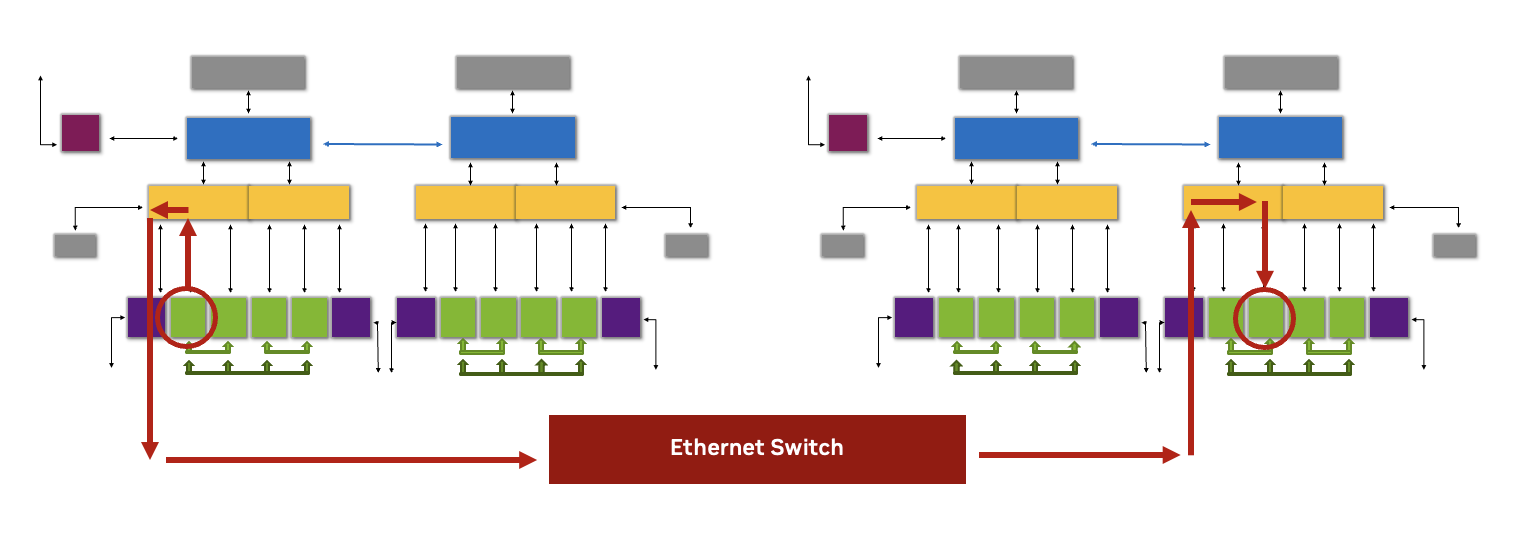

Şekil 2. Bu 2-8-5 yapılandırmasında GPU 1’in GPU 4 ile iletişim kurması ve verilerin NVLink üzerinden iletilmesi gerekiyor.

Şekil 3. Bu 2-8-5 yapılandırmasında bir GPU’nun başka bir düğümdeki bir GPU ile iletişim kurması ve GPU’lar arasındaki veri transferlerinin NVIDIA Spectrum Ethernet Anahtarı aracılığıyla RoCE’den yararlanması gerekir.

H200 NVL’nin Ölçekli Performansını Maksimize Etme

H200 NVL’nin özellikleri ve en uygun sunucu yapılandırmalarını ele aldıktan sonra, bu bölümde H200 NVL için NVIDIA Enterprise Referans Mimarisi kapsamında yer alan ve bu sistemleri küme ortamında dağıtırken işletmelerin performansı en üst düzeye çıkarmasına olanak tanıyan ek teknolojileri inceleyeceğiz.

NVIDIA Kolektif İletişim Kütüphanesi (NCCL)

H200 NVL için Enterprise Referans Mimarisi, birden çok GPU arasında verimli iletişim gerektiren dağıtılmış yapay zeka, derin öğrenme ve yüksek performanslı hesaplama (HPC) gibi iş yükleri için NVIDIA Kolektif İletişim Kütüphanesi (NCCL) kullanır.

NVIDIA hızlandırılmış hesaplama platformu için tam optimize edilmiş bu özel yazılım araç seti, bir küme içindeki birden fazla GPU arasındaki iletişimi geliştirir ve verilerin paylaşımını ve işlenmesini kolaylaştıran optimize edilmiş işlevler sunar. İster aynı sunucuda ister birden fazla sunucuya dağıtılmış olsun, NCCL, H200 NVL GPU’ları ve NVLink teknolojisiyle çalışarak çeşitli veri iletişim yollarını değerlendirir ve en uygun yolu seçer.

Bir örnek vermek gerekirse, NVIDIA Blueprints ile oluşturulan Agentic AI uygulamaları, NCCL optimizasyonundan önemli ölçüde fayda sağlar. Bu yapay zeka ajanları, birden fazla GPU’ya dağıtılmış çeşitli NIM mikro hizmetlerinden oluşur. Dolayısıyla, düşük gecikmeli iletişim, performans için kritik öneme sahiptir.

| Teknoloji | Yetenek |

|---|---|

| Spectrum-X (Yazılım ve Donanım) | Hem donanım hem de yazılım öğelerini optimize edilmiş AI iş yüklerine entegre eden kapsamlı çözüm. H200 NVL ile birlikte Spectrum-X, Spectrum-4 Ethernet Anahtarları, BlueField-3 SuperNIC’ler) ve Spectrum-X Yazılım Geliştirme Kitleri (SDK’lar) ve NCCL aracılığıyla verimli veri aktarımı ve iletişimi sağlar. |

| NCCL (Yazılım) | NCCL (yazılım) NCCL, H200 NVL için optimize edilmiş iletişim işlemleri sağlar. NCCL topolojiye duyarlıdır, NVLink gibi temel GPU ara bağlantı teknolojisini optimize edebilir ve NIC’lerin belirli yaprak anahtarlarına bağlandığı ray için optimize edilmiş topoloji tasarımlarından faydalanır. NCCL yük boşaltma kitaplığı, NCCL’nin bir parçasıdır ve toplu iletişim işlemlerinin ağa yüklenmesini sağlayarak CPU üzerindeki yükü azaltır ve performansı artırır. |

| NVLink Bridge (Yazılım) | NVLink Köprüsü (donanım) Dördüncü nesli H200 NVL’de kullanılan yüksek hızlı ara bağlantı teknolojisi. Dördüncü nesil NVLink, noktadan noktaya bağlantılardan önemli ölçüde daha yüksek olan GPU-GPU iletişimi için 900 GB/sn’lik yüksek bir bant genişliği sağlar. |

| SDKs | Spectrum-X SDK’ları H200 NVL ile çalışır ve Cumulus Linux, saf SONiC, NetQ ve NVIDIA DOCA yazılım çerçevelerini içerir. Bu SDK’lar, bozulma olmadan birden fazla AI iş yükünde performansı garantilemek için toplu olarak çalışır. |

| Yakınsanmış Ethernet (RoCE) GPU Direct üzerinden RDMA | Sunucular ve depolama dizileri arasında doğrudan bellek-bellek transferlerini sağlayan ve CPU katılımını atlayan, Yakınsanmış Ethernet Üzerinden RDMA (RoCE) GPU Doğrudan Ağ protokolü. H200 NVL sistemler arası iletişimdeki gecikme, RoCE tarafından azaltılırken, NVLink sistem içi GPU iletişimi için yanıt süresini azaltır. |

NVIDIA H200 NVL ile Güçlü Altyapılar İnşa Edin

Yüksek performansı ve gelişmiş özellikleriyle NVIDIA Hopper ailesinin en yeni üyesi olan H200 NVL, kurumsal düzeyde yapay zeka ve yüksek performanslı hesaplama(HPC) hızlandırmasında önemli bir ilerleme sağlar. Veri merkezi altyapısını dönüştürmeye hazır işletmeler, H200 NVL içeren çeşitli yapılandırmalardaki yeni nesil platformları, NVIDIA’nın küresel sistem ortakları ekosistemi aracılığıyla keşfedebilir.

H200 NVL için NVIDIA Enterprise Referans Mimarisi artık yüksek performanslı ve ölçeklenebilir veri merkezi çözümleri geliştiren iş ortakları için kullanılabilir. Bu Enterprise Referans Mimarisi, H200 NVL’yi ölçekli olarak devreye alırken kanıtlanmış ve kapsamlı tasarım önerileri sunarak veri merkezi altyapısını tasarlama ve dağıtma sürecindeki karmaşıklığı azaltır.

H200 NVL ve diger server ürünleri ilgili her türlü sorunuz ve talebiniz için [email protected] adresinden bizlere ulaşabilirsiniz. Ayrıca aşağıdaki form üzerinden bilgilerinizi doldurarak ekibimizin sizlerle iletişime geçmesini talep edebilirsiniz.

OPENZEKA HABERLERİ

OPENZEKA HABERLERİ

Hesaplarınızda paylaşmak ister misiniz?