Yapay zeka alanında bir sonraki büyük dalganın içerisinde yer almak istiyorsanız, bir transformer modeli de siz geliştirin.

Transformer modelleri, televizyonda gördüğünüz şekil değiştiren oyuncak robotlar ya da elektrik direklerindeki büyük yuvarlak boyutlu çöp kutusuna benzer tenekelerden değildir.

Pekala, O Zaman Bir Transformer Modeli Nedir?

Bir transformer modeli, bu cümledeki kelimeler gibi sıralı verilerdeki ilişkileri izleyerek bağlamı ve dolayısıyla anlamı öğrenen bir sinir ağıdır.

Transformer modelleri, bir dizideki birbirini etkileyen ve birbirine bağlı olan birbirinden uzak veri öğelerinin bile ince bağlantılarını tespit etmek için, ilgi veya öz-ilgi adı verilen ve hala gelişmekte olan bir dizi matematiksel teknik uygular.

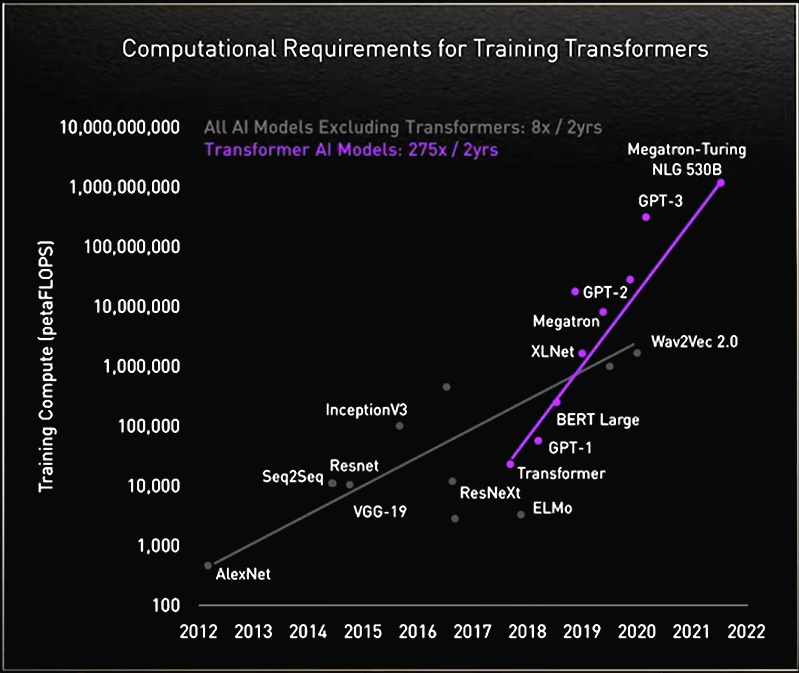

İlk olarak Google’ın 2017 tarihli bir makalesinde tanımlanan transformer modelleri, bugüne kadar icat edilmiş en yeni ve en güçlü model yapılarından biridir. Bu model yapıları makine öğrenmesi alanındaki gelişmelerin bayrak taşıyıcısı haline geldiği için bazı çevreler tarafından “dönüştürücü AI” olarak adlandırılmaktadır.

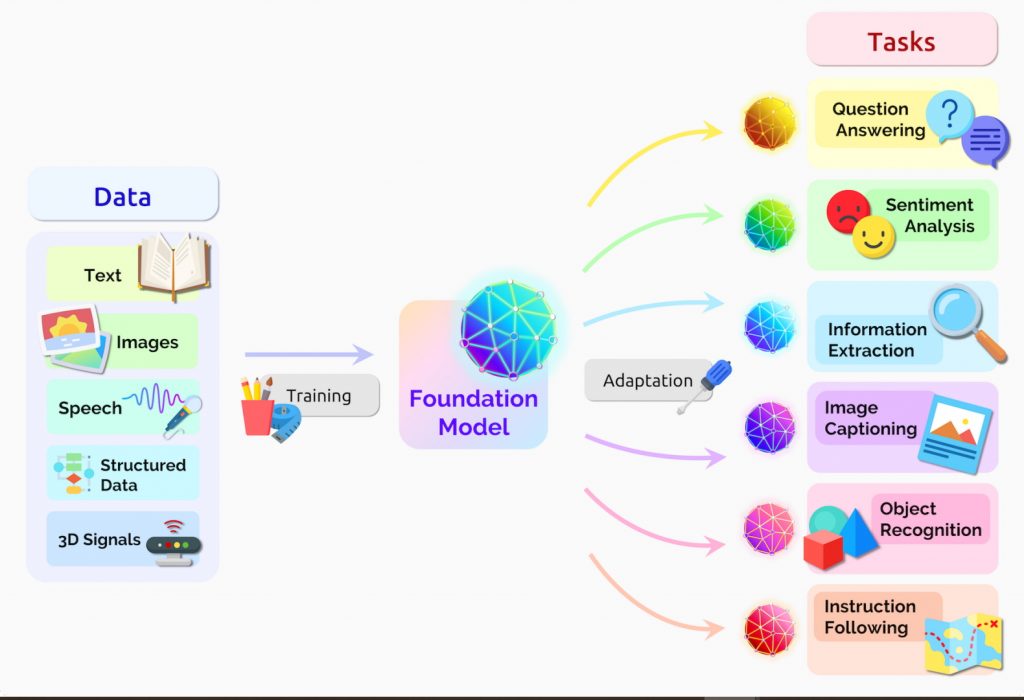

Stanford araştırmacıları, bu modellerin yapay zeka alanında yeni bir dönüm noktası oluşturacağını düşündükleri için Ağustos 2021 tarihli bir makalelerinde transformer modellerini “temel modeller” olarak adlandırdılar. Makalelerinde, “Son birkaç yıldır temel modellerin saf ölçek ve kapsamları, neyin mümkün olduğuna dair hayal gücümüzü genişletti” ifadesini kullandılar.

Transformer Modelleri Neler Yapabilir?

Transformerlar, metin ve konuşmayı neredeyse gerçek zamanlı olarak çevirerek, toplantıları ve sınıfları birçok kesimden ve işitme engelli katılımcılara açıyor.

Araştırmacıların DNA’daki gen zincirlerini ve proteinlerdeki amino asitleri ilaç tasarımını hızlandırabilecek şekilde anlamalarına yardımcı oluyorlar.

Transformerlar, dolandırıcılığı önlemek, üretimi kolaylaştırmak, çevrimiçi önerilerde bulunmak veya sağlık hizmetlerini iyileştirmek için eğilimleri ve anomalileri tespit edebilir.

İnsanlar, Google’da veya Microsoft Bing’de her arama yaptıklarında aslında transformer modellerini kullanmaktadır.

Transformer AI’ın Erdemli Döngüsü

Sıralı metin, görüntü veya video verilerini kullanan herhangi bir uygulama, transformer modelleri için bir adaydır. Bu durum, bu modellerin transformer AI sürecinde erdemli bir döngü sürmesini sağlar. Büyük veri kümeleriyle oluşturulan transformerlar, daha yaygın bir şekilde kullanılmalarını sağlayan yüksek doğrulukta tahminler yaparak daha da iyi modeller oluşturmak için kullanılabilecek daha fazla veri üretir.

NVIDIA’nın kurucu ve CEO’su Jensen Huang GTC’de yaptığı açılış konuşmasında, “Transformerlar kendi kendine denetimli öğrenmeyi mümkün kıldı ve yapay zeka alanında ışık hızında bir atılıma sebep oldu” dedi.

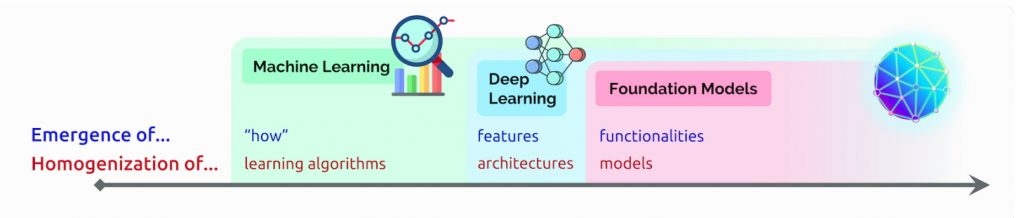

Transformer Modelleri, CNN ve RNN’lerin Yerini Alıyor

Transformerlar birçok kullanım alanında, yalnızca beş yıl önce en popüler derin öğrenme modelleri olan evrişimli sinir ağları ve tekrarlayan sinir ağlarının (CNN’ler ve RNN’ler) yerini alıyor.

Gerçekten de, son iki yılda yayınlanan AI hakkındaki arXiv makalelerinin yüzde 70’inde transformerlar bahsediliyor. Bu, RNN’lerin ve CNN’lerin örüntü tanıma için en popüler modeller olduğunu ortaya koyan 2017 tarihli IEEE çalışmasına göre radikal bir değişim.

Daha Az Etiket, Daha Fazla Performans

Transformerlardan önce kullanıcıların, oluşturması maliyetli ve zaman alıcı olan büyük, etiketli veri kümeleriyle sinir ağlarını eğitmesi gerekiyordu. Transformerlar, elemanlar arasındaki örüntüleri matematiksel yaklaşım ile tespit edip bu ihtiyacı ortadan kaldırarak trilyonlarca görüntüyü ve petabaytlarca metin verisini web’de ve kurumsal veritabanlarında kullanılabilir hale getirdiler.

Ayrıca, transformerların kullandığı matematiksel hesaplamalar paralel işlemeye elverişlidir ve böylece bu modeller hızlı çalışabilir.

Transformerlar artık dil işleme sistemleri için 2019’da geliştirilen bir performans kıyaslama aracı olan SuperGLUE gibi popüler performans liderliği tablolarına hükmediyor.

Transformerlar İlgileri Nasıl Ayırt Ediyor?

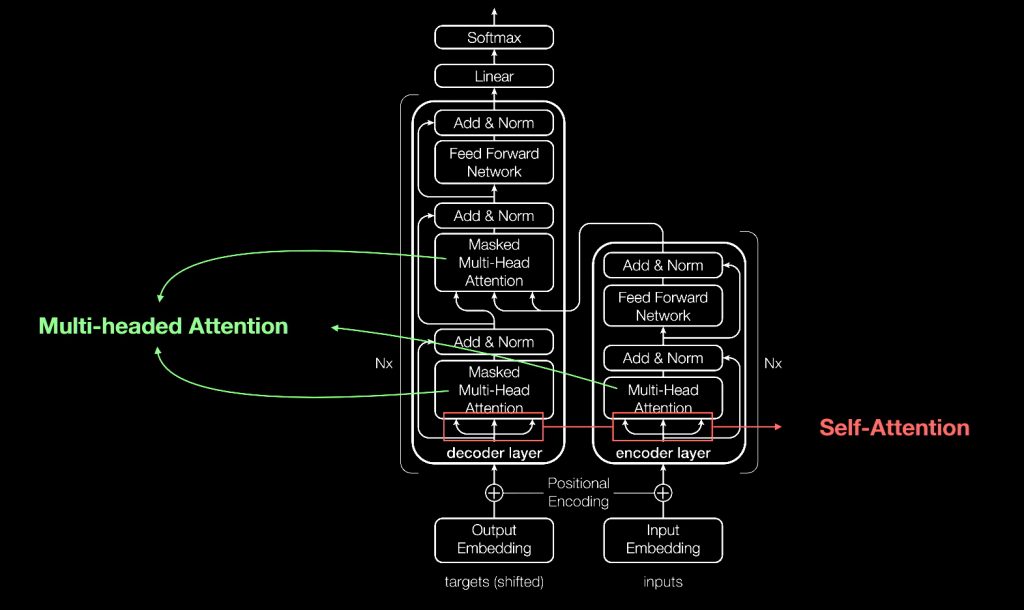

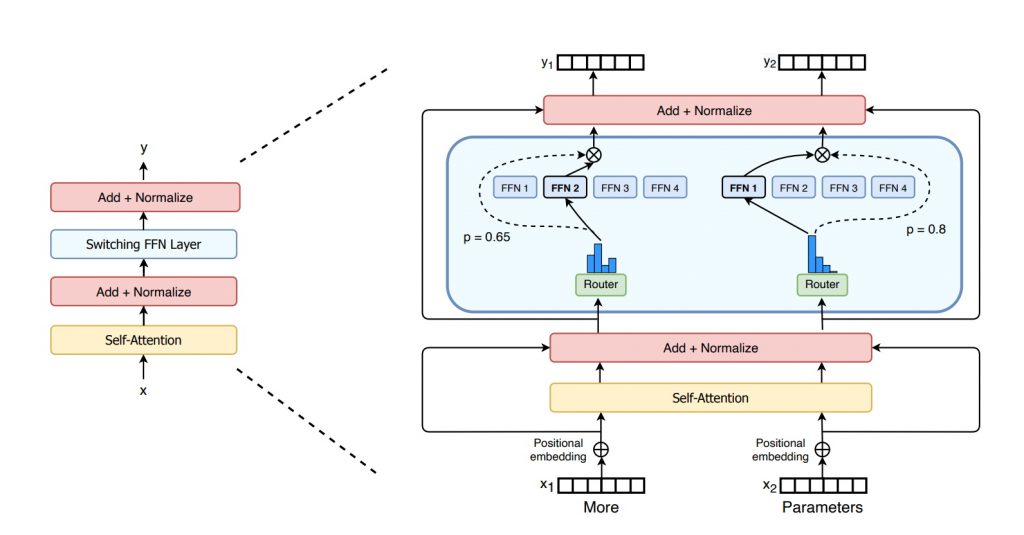

Çoğu sinir ağı gibi, transformer modelleri temelde verileri işleyen büyük kodlayıcı/kod çözücü bloklardır. Bu bloklara aşağıdaki şemada gösterildiği gibi yapılan küçük ama stratejik eklemeler, transformerları benzersiz bir şekilde güçlü kılar.

Transformerlar, ağa giren ve çıkan veri öğelerini etiketlemek için konumsal kodlayıcıları kullanır. İlgi birimleri bu etiketleri takip ederek her bir öğenin diğerleriyle nasıl ilişkili olduğuna dair bir tür cebirsel harita hesaplar.

İlgi sorguları “çok yönlü ilgi” olarak adlandırılan bir denklem matrisi hesaplamaları ile paralel olarak yürütülür.

Bu araçlarla bilgisayarlar, insanların gördüğüyle aynı örüntüleri görebilir.

Öz İlgi Anlam Kazanıyor

Örneğin, aşağıdaki cümlede:

Sürahiden bardağa dolana kadar su koydu.

“dolana kadar” kısmı ile bardağın kastedilirken; aşağıdaki cümlede:

Sürahiden bardağa boşalana kadar su döktü.

“boşalana kadar” kısmı ile sürahinin kastedildiğini biliyoruz.

Yeni ufuklar açan 2017’deki makalede çalışmaya öncülük eden Google Brain’in eski kıdemli araştırma bilimcisi Ashish Vaswani, “Anlam, bir şeyler arasındaki ilişkilerin bir sonucudur ve öz ilgi, ilişkileri öğrenmenin genel bir yoludur” diyor.

Vaswani, “Makine çevirisi, öz ilgiyi doğrulamak için iyi bir araçtı çünkü kelimeler arasında kısa ve uzun mesafeli ilişkilere ihtiyacınız vardı” dedi ve “Artık öz ilginin öğrenme için güçlü ve esnek bir araç olduğunu görüyoruz” diye ekledi.

Transformer İsminin Ortaya Çıkışı

İlgi terimi, transformer modelleri için o kadar önemlidir ki, Google araştırmacıları 2017’deki modelleri için bu terimi neredeyse modele isim olarak veriyorlardı. Neredeyse…

2011 yılında sinir ağlarıyla çalışmaya başlayan Vaswani, “İlgi Ağı kulağa pek heyecan verici gelmedi” dedi.

Ekipte kıdemli bir yazılım mühendisi olan Jakob Uszkoreit, Transformer adını buldu.

Vaswani, “Temsilleri dönüştürdüğümüz ile ilgili konuştuk ancak bu sadece bir kelime oyunuydu” dedi.

Transformerların Doğuşu

Google ekibi, 2017 NeurIPS konferans makalesinde, trasnformer modellerini ve makine çevirisi için ayarladığı doğruluk seviyelerini ortaya koydu.

Bir dizi teknik sayesinde, modellerini yalnızca 3,5 günde sekiz NVIDIA GPU’su üzerinde eğittiler. Önceki modellerle kıyaslandığında bu süre, eğitim zaman ve maliyetinin küçük bir kısmını oluşturuyordu. Modeli, bir milyar çift kelimeye kadar olan veri barındıran veri kümeleri üzerinde eğittiler.

2017 yılında çalışmaya katkıda bulunan bir Google stajyeri olan Aidan Gomez, “Makale teslim tarihine kadar üç aylık yoğun bir koşuşturmacaydı” sözleriyle geliştirme sürecini hatırlıyor.

“Çalışmayı gönderdiğimiz gece, Ashish ve ben Google’da bütün gece çalıştık” dedi. “Küçük konferans odalarından birinde birkaç saat uykuya daldım ve işe erken gelen biri kapıyı açarak kafama çarpıp beni uyandırdığında, tam çalışma teslim anıydı.”

Birçok açıdan bir uyandırma alarmıydı.

Şimdilerde transformer modellerine dayalı bir dil işleme hizmeti sunan Cohere girişiminin CEO’su Gomez, “Ashish o gece bana bunun çok büyük bir olay olacağına, oyunun kurallarını değiştireceğine inandığını söyledi. Ben, ikna olmadım; bunun bir kıyaslama tablosunda mütevazı bir ilerleyiş olacağını düşündüm ancak onun çok daha haklı olduğu ortaya çıktı” dedi.

Makine Öğrenmesi İçin Bir Dakikalık Saygı Duruşu

Vaswani, model sonuçlarının, CNN’leri kullanan bir Facebook ekibi tarafından yayınlanan benzer çalışmaları geride bıraktığını görmenin heyecanını hatırlıyor.

“Bunun, makine öğrenmesinde önemli bir an olacağını görebiliyordum” dedi.

Bir yıl sonra, başka bir Google ekibi, metin dizilerini bir transformer ile hem ileriye hem de geriye doğru işlemeyi denedi. Bu, kelimeler arasında daha fazla ilişki yakalamaya yardımcı oldu ve modelin bir cümlenin anlamını algılama yeteneğini geliştirdi.

Transformers Tabanlı Çift Yönlü Kodlayıcı Temsilleri (Bidirectional Encoder Representations from Transformers – BERT) modeli 11 yeni rekor kırdı ve Google arama motorunun arkasındaki algoritmanın bir parçası oldu.

20 yıllık makine öğrenmesi araştırma uzmanı Anders Arpteg, haftalar içinde dünyanın dört bir yanındaki araştırmacıların BERT’i birçok dil ve sektördeki kullanım örneklerine uyarlamaları hakkında “çünkü metin, şirketlerin sahip olduğu en yaygın veri türlerinden birisi” dedi.

Transformer Modellerinin Uygulamaya Konulması

Yakın bir geçmişte transformer modelleri bilim ve sağlık için uyarlanmaya başladı.

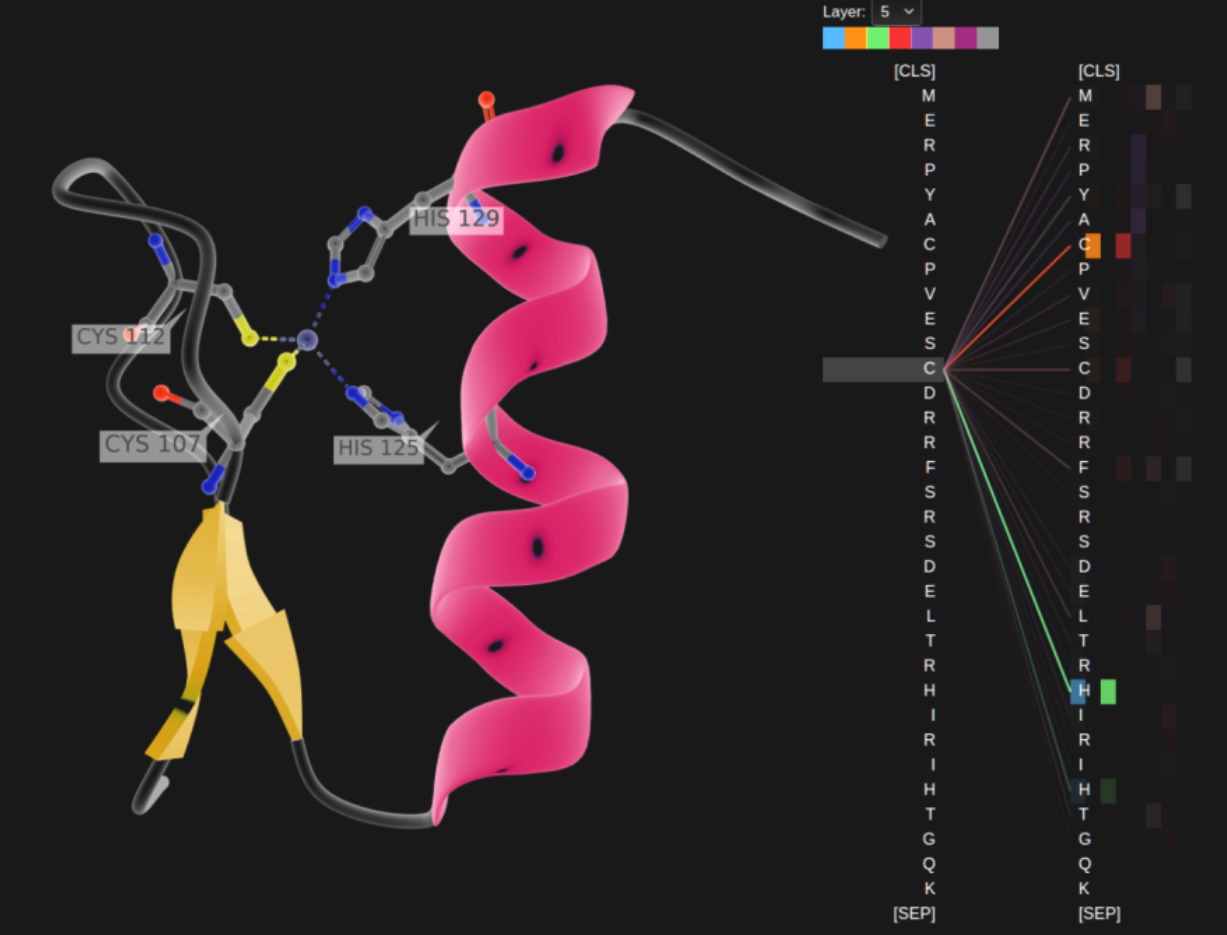

DeepMind, Londra’da yakın tarihli bir Nature makalesinde ortaya atılan AlphaFold2 adlı bir transformer modeli kullanarak yaşamın yapı taşları olan proteinlerin anlaşılmasını geliştirdi. İlaç geliştirme sürecini hızlandırabilecek bir proje olarak, proteinlerin nasıl katlandığını tarif etmek için amino asit zincirlerini metin dizileri gibi işledi.

AstraZeneca ve NVIDIA, ilaç keşfi için özel olarak tasarlanmış bir transformer olan MegaMolBART’ı geliştirdi. İlaç firmasının kendi geliştirdiği MolBART transformer modelinin bir versiyonu olan bu model, büyük ölçekli transformer modelleri oluşturmak için NVIDIA Megatron kütüphanesi kullanılarak büyük,

etiketlenmemiş bir kimyasal bileşik veritabanı üzerinde eğitilmiştir.

Molekülleri ve Tıbbi Kayıtları Okumak

Çalışma geçen yıl duyurulduğunda AstraZeneca’da moleküler AI, yapay zeka, keşif bilimleri ve Ar-Ge bölüm başkanı olan Ola Engkvist, “Amacımız; tıpkı AI dil modellerinin, bir cümledeki kelimeler arasında bulunan ilişkileri öğrenebildiği gibi, moleküler yapı verileri üzerinde eğitilmiş sinir ağlarının gerçek dünyada karşılaştığımız moleküllerde bulunan atomlar arasındaki ilişkileri de öğrenebilmesidir” dedi.

Ayrıca, Florida Üniversitesi’nin akademik sağlık merkezi, GatorTron’u oluşturmak için NVIDIA araştırmacılarıyla işbirliği yaptı. Ortaya çıkan transformer modelinin amacı, tıbbi araştırmaları hızlandırmak için büyük hacimli klinik verilerden akıllı analiz sonuçları elde etmektir.

Transformerlar Büyüyor

Süreç boyunca araştırmacılar, daha büyük transformer modellerinin daha iyi performans gösterdiğini buldular.

Örneğin, AI ve biyolojinin kesişiminde öncü çalışmalara yardımcı olan Münih Teknik Üniversitesi’ndeki

Rostlab’dan araştırmacılar, proteinleri anlamak için doğal dil işlemeyi kullandılar. 18 ayda, 90 milyon parametreli RNN’lerden 567 milyon parametreli transformer modellerine geçiş yaptılar.

OpenAI laboratuvarı, Generative Pretrained Transformer (GPT) ile daha büyük olanın daha iyi olduğunu gösterdi. En son sürüm olan GPT-3; 1.5 milyar parametreye sahip olan GPT-2’ye kıyasla 175 milyar parametreye sahiptir.

Fazladan bir ek çalışma ile GPT-3, özellikle işlemek için eğitilmediği görevlerde bile bir kullanıcının sorgusuna yanıt verebiliyor. Halihazırda Cisco, IBM ve Salesforce gibi şirketler tarafından kullanılıyor.

Mega Transformerların Öyküsü

NVIDIA ve Microsoft, Kasım ayında 530 milyar parametreye sahip Megatron-Turing Doğal Dil Üretici modelini (MT-NLG) duyurarak yüksek bir başarı seviyesi elde etti. Herhangi bir işletmenin özel sohbet robotlarına, kişisel asistanlara ve dil anlama kabiliyetine sahip diğer AI uygulamalarına güç vermek için kendi milyar veya trilyon parametreli transformer modellerini oluşturmasına olanak vermeyi amaçlayan yeni bir kütüphane; NVIDIA NeMo Megatron ile birlikte piyasaya çıktı.

MT-NLG, NVIDIA’nın Kasım 2021 GTC’sinde açılış konuşmasını yapan Toy Jensen avatarı TJ’in beyni olarak ilk kez sahneye çıktı.

Modeli eğiten NVIDIA ekibininin lideri Mostofa Patwary, “CEO’muz tarafından gösterimi yapılan çalışmamızın gücü olarak, TJ’in soruları yanıtladığını görmek heyecan vericiydi” dedi.

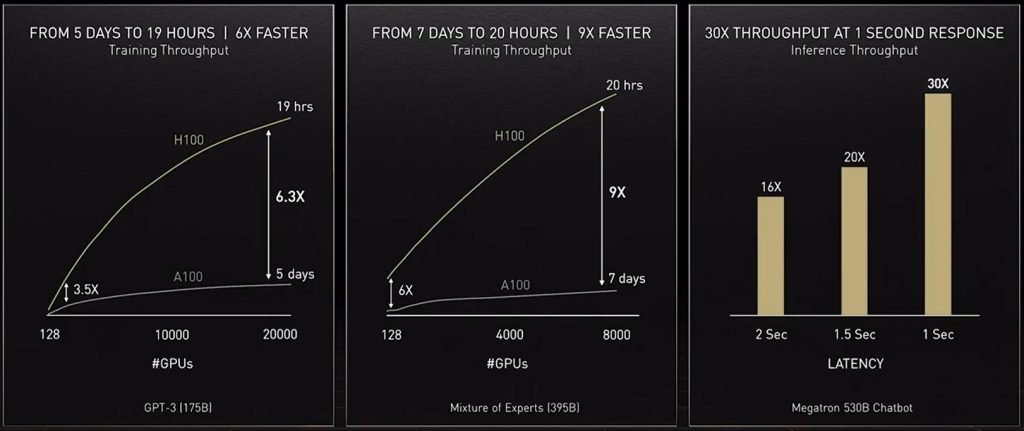

Bu tür modeller oluşturmak, herkesin yapabileceği bir şey değildir. MT-NLG, binlerce GPU’nun haftalarca çalışmasını gerektiren bir süreç ile yüz milyarlarca veri öğesi kullanılarak eğitildi.

Patwary, “Büyük transformer modellerini eğitmek maliyetli ve zaman alıcıdır. Bu nedenle ilk veya ikinci seferde başarılı olamazsanız projeler iptal edilebilir” dedi.

Trilyon Parametreli Transformerlar

Bugün birçok AI mühendisi, trilyon parametreli transformerlar ve bağlantılı uygulamalar üzerinde çalışıyor.

Patwary, “Bu büyük modellerin nasıl daha iyi uygulamalar sunabileceğini sürekli araştırıyoruz. Ayrıca hangi yönlerden başarısız olduklarını da araştırıyoruz. Böylece daha da iyilerini ve daha büyüklerini inşa edebiliriz” dedi.

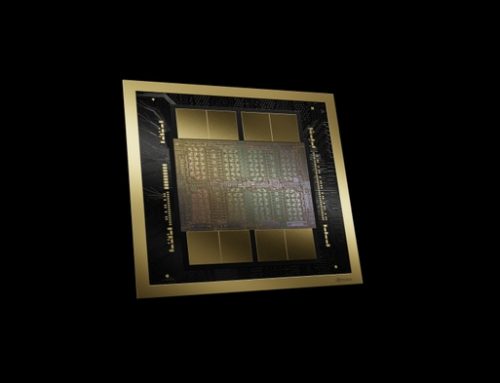

En son hızlandırıcımız olan NVIDIA H100 Tensor Core GPU, bu modellerin ihtiyaç duyduğu bilgi işlem gücünü sağlamak için bir Transformer Engine içerir ve yeni bir format olan FP8’i destekler. Bu, başarımı korurken eğitim sürecini hızlandırır.

Huang GTC’de, bu ve diğer gelişmeler sayesinde “transformatör modeli eğitimi haftalardan günlere düşürülebilir” dedi.

MoE, Transformerlar için Daha Fazlası Demektir

Geçen yıl, Google araştırmacıları ilk trilyon parametreli modellerden biri olan Switch Transformer’ı ortaya koydu. Bu çalışmada, dil işlemedeki performans kazanımları ve eğitim öncesi hızda 7 kata kadar artış sağlamak için AI seyrekliği, karmaşık bir mixture of experts (MoE) mimarisi ve diğer geliştirmeleri kullanılmaktadır.

Microsoft Azure, kendi sistemlerindeki Çevirmen hizmeti için bir MoE transformerın adapte edilmesi adına NVIDIA ile birlikte çalıştı.

Transformerların Zorluklarıyla Mücadele

Şimdi bazı araştırmacılar, en büyük modellere benzer performans sağlayan daha az parametreli ve daha basit transformer modelleri geliştirmeyi hedefliyor.

Cohere’den Gomez, DeepMind’ın Retro modelini örnek göstererek, “Eğriyi bükebilecekleri için çok heyecanlı olduğum retrieval tabanlı modellerde umut görüyorum” dedi.

Retrieval tabanlı modeller, bir veritabanına sorgular göndererek öğrenir. “Bu harika çünkü bu bilgi tabanına ne koyacağınız konusunda seçici olabilirsiniz” dedi.

Şimdi gizli bir yapay zeka girişiminin kurucu ortağı olan Vaswani, nihai hedefin “bu modellerin, insanların gerçek dünyadaki bağlamdan çok az veri ile yaptığı gibi öğrenmesini sağlamak” olduğunu söyledi.

Vaswani, önden daha fazla hesaplama yapan, böylece daha az veriye ihtiyaç duyan ve kullanıcıların onlara geri bildirimde bulunabilecekleri daha iyi yöntemler sunan gelecekteki modelleri hayal ediyor.

Yeni girişimi hakkında ise “Amacımız, insanlara günlük yaşamlarında yardımcı olacak modeller oluşturmak” dedi.

Güvenli ve Sorumluluk Sahibi Modeller

Diğer araştırmacılar, modeller yanlış veya zararlı bir konuşma diline güç veriyorsa, yönelim veya toksisiteyi ortadan kaldırmanın yollarını araştırıyorlar. Örneğin Stanford, bu sorunları araştırmak için Temel Modeller Araştırma Merkezi’ni kurdu.

NVIDIA’da bu alanda çalışan pek çok sektörden biri olan araştırma bilimcisi Shrimai Prabhumoye, “Bunlar, modellerin güvenli bir şekilde konuşlandırılması için çözülmesi gereken önemli sorunlardır” dedi.

Prabhumoye, “Bugün, çoğu model belirli kelimeler veya ifadeler arar, ancak gerçek hayatta bu sorunlar kurnaz bir şekilde ortaya çıkabilir. Bu nedenle tüm bağlamı göz önünde bulundurmalıyız” diye ekledi.

Gomez ise “Bu, Cohere için de birincil endişe kaynağı” dedi ve ekledi: “İnsanları incitirse, hiç kimse bu modelleri kullanmayacak. Bu yüzden en güvenli ve en sorumlu modelleri yapmak masaya yatırılır.”

Ufkun Ötesinde

Vaswani, kendi kendine öğrenen, dikkatle çalışan transformerların yapay zekanın kutsal kasesine yaklaştığı bir gelecek hayal ediyor.

“İnsanların ‘genel yapay zeka’ terimini kullandıklarında bahsettiği bazı hedeflere ulaşma şansımız var ve bu kuzey yıldızını çok ilham verici buluyorum” dedi.

“Sinir ağları gibi basit yöntemlerin bize yeni yetenekler patlaması sağladığı bir zamandayız.”

Yazının kaynağına buradan ulaşabilirsiniz.

OPENZEKA HABERLERİ

OPENZEKA HABERLERİ

Hesaplarınızda paylaşmak ister misiniz?

Çok güzel ve öğretici bir yazı olmuş, teşekkür ederim.

[…] uygulamaları arasındadır. Transformer modellerinin ne olduğunu daha detaylı incelemek için Transformer Modeli Nedir? ‘e bakabilirsiniz. Transformer modelleri yapay zekaya yalnızca insan dillerini öğreten […]